Навигация

Обзор современных технологий позиционирования звука в пространстве

5. Обзор современных технологий позиционирования звука в пространстве

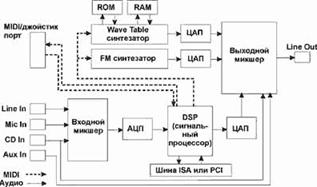

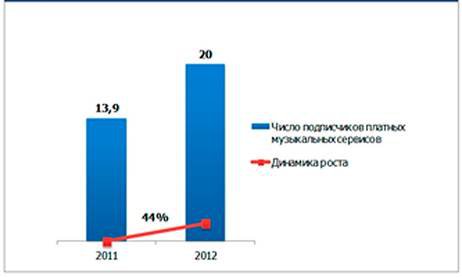

Звуковое сопровождение компьютера всегда находилось несколько на втором плане. Большинство пользователей более охотно потратят деньги на новейший акселератор 3D графики, нежели на новую звуковую карту. Однако за последний год производители звуковых чипов и разработчики технологий 3D звука приложили немало усилий, чтобы убедить пользователей и разработчиков приложений в том, что хороший 3D звук является неотъемлемой частью современного мультимедиа компьютера. Пользователей убедить в пользе 3D звука несколько легче, чем разработчиков приложений. Достаточно расписать пользователю то, как источники звука будет располагаться в пространстве вокруг него, т.е. звук будет окружать слушателя сов всех сторон и динамично изменяться, как многие потянутся за кошельком. С разработчиками игр и приложений сложнее. Их надо убедить потратить время и средства на реализацию качественного звука. А если звуковых интерфейсов несколько, то перед разработчиком игры встает проблема выбора. Сегодня есть два основных звуковых интерфейса, это DirectSound3D от Microsoft и A3D от Aureal. При этом если разработчик приложения предпочтет A3D, то на всем аппаратном обеспечении DS3D будет воспроизводиться 3D позиционируемый звук, причем такой же, как если бы изначально использовался интерфейс DS3D. Само понятие "трехмерный звук" подразумевает, что источники звука располагаются в трехмерном пространстве вокруг слушателя. Это основа. Далее, что бы придать звуковой модели реализм и усилить восприятие звука слушателем, используются различные технологии, обеспечивающие воспроизведение реверберации, отраженных звуков, окклюзии (звук прошедший через препятствие), обструкции (звук не прошел через препятствие), дистанционное моделирование (вводится параметр удаленности источника звука от слушателя) и масса других интересных эффектов. Цель всего этого, создать у пользователя реальность звука и усилить впечатления от видео ряда в игре или приложении. Не секрет, что слух это второстепенное чувство человека, именно поэтому, каждый индивидуальный пользователь воспринимает звук по-своему. Никогда не будет однозначного мнения о звучании той или иной звуковой карты или эффективности той или иной технологии 3D звука. Сколько будет слушателей, столько будет мнений. В данной статье мы попытались собрать и обобщить информацию о принципах создания 3D звука, а также рассказать о текущем состоянии звуковой компьютерной индустрии и о перспективах развития. Мы уделим отдельное внимание необходимым составляющим хорошего восприятия и воспроизведения 3D звука, а также расскажем о некоторых перспективных разработках. Некоторые данные в статье рассчитаны на подготовленного пользователя, однако, никто не мешает пропустить нудные формулы тем, кому это не интересно или давно надоело в институте.

Итак, наверняка почти все слышали, что для позиционирования источников звука в виртуальном 3D пространстве используются HRTF функции. Ну что же, попробуем разобраться в том, что такое HRTF и действительно ли их использование так эффективно.

Сколько раз происходило следующее: команда, отвечающая за звук, только что закончила встраивание 3D звукового интерфейса на базе HRTF в новейшую игру; все комфортно расселись, готовясь услышать "звук окружающий вас со всех сторон" и "свист пуль над вашей головой"; запускается демо версия игры и… и ничего подобного вы просто не слышите!

HRTF (Head Related Transfer Function) это процесс посредством которого наши два уха определяют слышимое местоположение источника звука; наши голова и туловище являются в некоторой степени препятствием, задерживающим и фильтрующим звук, поэтому ухо, скрытое от источника звука головой воспринимает измененные звуковые сигналы, которые при "декодировании" мозгом интерпретируются соответствующим образом для правильного определения местоположения источника звука. Звук, улавливаемый нашим ухом, создает давление на барабанную перепонку. Для определения создаваемого звукового давления необходимо определить характеристику импульса сигнала от источника звука, попадающего на барабанную перепонку, т.е. силу, с которой звуковая волна отlисточника звука воздействует на барабанную перепонку. Эту зависимость называют Head Related Impulse Response (HRIR), а ее интегральное преобразование по Фурье называется HRTF.

Правильнее характеризовать акустические источники скоростью распространяемых ими звуковых волн V(t), нежели давлением P(t) распространяемой звуковой волны. Теоретически, давление, создаваемой идеальным точечным источником звука бесконечно, но ускорение распространяемой звуковой волны есть конечная величина. Если вы достаточно удалены от источника звука и если вы находитесь в состоянии "free field" (что означает, что в окружающей среде нет ничего кроме, источника звука и среды распространения звуковой волны), тогда давление "free field" (ff) на расстоянии "r" от источника звука определяется по формуле

Pff(t) = Zo V(t - r/c) / r где Zo это постоянная называемая волновым сопротивлением среды (characteristic impedance of the medium), а "c" это скорость распространения звука в среде. Итак, давление ff пропорционально скорости в начальный период времени (происход "сдвиг" по времени, обусловленный конечной скоростью распространения сигнала. То есть возмущение в этой точке описывается скоростью источника в момент времени отстоящий на r/c - время которое затрачено на то, чтобы сигнал дошел до наблюдателя. В принципе не зная V(t) нельзя утверждать характера изменения скорости при сдвиге, т.е. произойдет замедление или ускорение) и давление уменьшается обратно пропорционально расстоянию от источника звука до пункта наблюдения.

С точки зрения частоты давление звуковой волны можно выразить так:

Pff(f) = Zo V(f) exp(- i 2 pi r/c) / r где "f" это частота в герцах (Hz), i = sqrt(-1), а V(f) получается в результате применения преобразования Фурье к скорости распространения звуковой волны V(t). Таким образом, задержки при распространении звуковой волны можно охарактеризовать "phase factor", т.е. фазовым коэффициентом exp(- i 2 pi r /c). Или, говоря словами, это означает, что функция преобразования в "free field" Pff(f) просто является результатом произведения масштабирующего коэффициента Zo, фазового коэффициента exp(- i 2 pi r /c) и обратно пропорциональна расстоянию 1/r. Заметим, что возможно более рационально использовать традиционную циклическую частоту, равную 2*pi*f чем просто частоту.

Если поместить в среду распространения звуковых волн человека, тогда

звуковое поле вокруг человека искажается за счет дифракции (рассеивания или иначе говоря различие скоростей распространения волн разной длины), отражения и дисперсии (рассредоточения) при контакте человека со звуковыми волнами. Теперь все тот же источник звука будет создавать несколько другое давление звука P(t) на барабанную перепонку в ухе человека. С точки зрения частоты это давление обозначим как P(f). Теперь, P(f), как и Pff(f) также содержит фазовый коэффициент, чтобы учесть задержки при распространении звуковой волны и вновь давление ослабевает обратно пропорционально расстоянию. Для исключения этих концептуально незначимых эффектов HRTF функция H определяется как соотношение P(f) и Pff(f). Итак, строго говоря, H это функция, определяющая коэффициент умножения для значение давления звука, которое будет присутствовать в центре головы слушателя, если нет никаких объектов на пути распространения волны, в давление на барабанную перепонку в ухе слушателя.

Обратным преобразованием Фурье функции H(f) является функция H(t), представляющая собой HRIR (Head-Related Impulse Response). Таким образом, строго говоря, HRIR это коэффициент (он же есть отношение давлений, т.е. безразмерен; это просто удобный способ загнать в одну букву в формуле очень сложный параметр), который определяет воздействие на барабанную перепонку, когда звуковой импульс испускается источником звука, за исключением того, что мы сдвинули временную ось так, что t=0 соответствует времени, когда звуковая волна в "free field" достигнет центра головы слушателя. Также мы масштабировали результаты таким образом, что они не зависят от того, как далеко источник звука расположен от человека, относительно которого производятся все измерения.

Если пренебречь этим временным сдвигом и масштабированием расстояния до источника звука, то можно просто сказать, что HRIR - это давление воздействующее на барабанную перепонку, когда источник звука является импульсным.

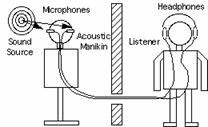

Напомним, что интегральным преобразованием Фурье функции HRIR является HRTF функция. Если известно значение HRTF для каждого уха, мы можем точно синтезировать бинауральные сигналы от монофонического источника звука (monaural sound source). Соответственно, для разного положения головы относительно источника звука задействуются разные HRTF фильтры. Библиотека HRTF фильтров создается в результате лабораторных измерений, производимых с использованием манекена, носящего название KEMAR (Knowles Electronics Manikin for Auditory Research, т.е. манекен Knowles Electronics для слуховых исследований) или с помощью специального "цифрового уха" (digital ear), разработанного в лаборатории Sensaura, располагаемого на голове манекена. Понятно, что измеряется именно HRIR, а значение HRTF получается путем преобразования Фурье. На голове манекена располагаются микрофоны, закрепленные в его ушах. Звуки воспроизводятся через акустические колонки, расположенные вокруг манекена и происходит запись того, что слышит каждое "ухо".

HRTF представляет собой необычайно сложную функцию с четырьмя переменными: три пространственных координаты и частота. При использовании сферических координат для определения расстояния до источников звука больших, чем один метр, считается, что источники звука находятся в дальнем поле (far field) и значение HRTF уменьшается обратно пропорционально расстоянию. Большинство измерений HRTF производится именно в дальнем поле, что существенным образом упрощает HRTF до функции азимута (azimuth), высоты (elevation) и частоты (frequency), т.е. происходит упрощение, за счет избавления от четвертой переменной. Затем при записи используются полученные значения измерений и в результате, при проигрывании звук (например, оркестра) воспроизводится с таким же пространственным расположением, как и при естественном прослушивании. Техника HRTF используется уже несколько десятков лет для обеспечения высокого качества стерео записей. Лучшие результаты получаются при прослушивании записей одним слушателем в наушниках.

Наушники, конечно, упрощают решение проблемы доставки одного звука к одному уху и другого звука к другому уху. Тем не менее, использование наушников имеет и недостатки. Например:

· Многие люди просто не любят использовать наушники. Даже легкие беспроводные наушники могут быть обременительны. Наушники, обеспечивающие наилучшую акустику, могут быть чрезвычайно неудобными при длительном прослушивании.

· Наушники могут иметь провалы и пики в своих частотных характеристиках, которые соответствуют характеристикам ушной раковины. Если такого соответствия нет, то восприятие звука, источник которого находится в вертикальной плоскости, может быть ухудшено. Иначе говоря, мы будем слышать преимущественно только звук, источники которого находится в горизонтальной плоскости.

· При прослушивании в наушниках, создается ощущение, что источник звука находится очень близко. И действительно, физический источник звука находится очень близко к уху, поэтому необходимая компенсация для избавления от акустических сигналов влияющих на определение местоположения физических источников звука зависит от расположения самих наушников.

Использование акустических колонок позволяет обойти большинство из этих проблем, но при этом не совсем понятно, как можно использовать колонки для воспроизведения бинаурального звука (т.е. звука, предназначенного для прослушивания в наушниках, когда часть сигнала предназначена для одного уха, а другая часть для другого уха). Как только мы подключим вместо наушников колонки, наше правое ухо начнет слышать не только звук, предназначенный для него, но и часть звука, предназначенную для левого уха. Одним из решений такой проблемы является использование техники cross-talk-cancelled stereo или transaural stereo, чаще называемой просто алгоритм crosstalk cancellation (для краткости CC).

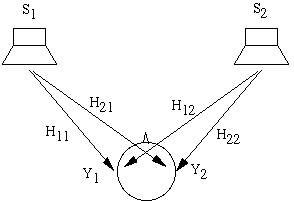

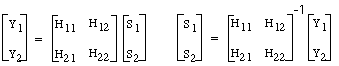

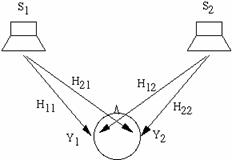

Идея CC просто выражается в терминах частот. На схемы выше сигналы S1 иS2 воспроизводятся колонками. Сигнал Y1 достигающий левого уха представляет собой смесь из S1 и "crosstalk" (части) сигнала S2. Чтобы быть более точными, Y1=H11 S1 + H12 S2, где H11 является HRTF между левой колонкой и левым ухом, а H12 это HRTF между правой колонкой и левым ухом. Аналогично Y2=H21 S1 + H22 S2. Если мы решим использовать наушники, то мы явно будем знать искомые сигналы Y1 и Y2 воспринимаемые ушами. Проблема в том, что необходимо правильно определить сигналы S1 и S2, чтобы получить искомый результат. Математически для этого просто надо обратить уравнение:

На практике, обратное преобразование матрицы не является тривиальной задачей.

· При очень низкой частоте звука, все функции HRTF одинаковы и поэтому матрица является вырожденной, т.е. матрицей с нулевым детерминантом (это единственная помеха для тривиального обращения любой квадратной матрицы). На западе такие матрицы называют сингулярными. (К счастью, в среде отражающей звук, т.е. где присутствует реверберация, низкочастотная информация не являются важной для определения местоположения источника звука).

· Точное решение стремиться к результату с очень длинными импульсными характеристиками. Эта проблема становится все более и более сложной, если в дальнейшем искомый источник звука располагается вне линии между двумя колонками, т.е. так называемый фантомный источник звука.

· Результат будет зависеть от того, где находится слушатель по отношению к колонкам. Правильное восприятие звучания достигается только в районе так называемого "sweet spot", предполагаемого месторасположения слушателя при обращении уравнения. Поэтому, то, как мы слышим звук, зависит не только от того, как была сделана запись, но и от того, из какого места между колонками мы слушаем звук.

При грамотном использовании алгоритмов CC получаются весьма хорошие результаты, обеспечивающие воспроизведение звука, источники которого расположены в вертикальной и горизонтальной плоскости. Фантомный источник звука может располагаться далеко вне пределов линейного сегмента между двумя колонками.

Давно известно, что для создания убедительного 3D звучания достаточно двух звуковых каналов. Главное это воссоздать давление звука на барабанные перепонки в левом и правом ушах таким же, как если бы слушатель находился в реальной звуковой среде.

Из-за того, что расчет HRTF функций сложная задача, во многих системах пространственного звука (spatial audio systems) разработчики полагаются на использование данных, полученных экспериментальным путем, например, данные получаются с помощью KEMAR. Тем не менее, основной причиной использования HRTF является желание воспроизвести эффект elevation (звук в вертикальной плоскости), наряду с азимутальными звуковыми эффектами. При этом восприятие звуковых сигналов, источники которых расположены в вертикальной плоскости, чрезвычайно чувствительно к особенностям каждого конкретного слушателя. В результате сложились четыре различных метода расчета HRTF:

· Использование компромиссных, стандартных HRTF функций. Такой метод обеспечивает посредственные результаты при воспроизведении эффектов elevation для некоторого процента слушателей, но это самый распространенный метод в недорогих системах. На сегодня, ни IEEE, ни ACM, ни AES не определили стандарт на HRTF, но похоже, что компании типа Microsoft и Intel создадут стандарт де-факто.

· Использование одной типа HRTF функций из набора стандартных функций. В этом случае необходимо определить HRTF для небольшого числа людей, которые представляют все различные типы слушателей, и предоставить пользователю простой способ выбрать именно тот набор HRTF функций, который наилучшим образом соответствует ему (имеются в виду рост, форма головы, расположение ушей и т.д.). Несмотря на то, что такой метод предложен, пока никаких стандартных наборов HRTF функций не существует.

· Использование индивидуализированных HRTF функций. В этом случае необходимо производить определение HRTF исходя из параметров конкретного слушателя, что само по себе сложная и требующая массы времени процедура. Тем не менее, эта процедура обеспечивает наилучшие результаты.

· Использование метода моделирования параметров определяющих HRTF, которые могут быть адаптированы к каждому конкретному слушателю. Именно этот метод сейчас применяется повсеместно в технологиях 3D звука.

На практике существуют некоторые проблемы, связанные с созданием базы HRTF функций при помощи манекена. Результат будет соответствовать ожиданиям, если манекен и слушатель имеют головы одинакового размера и формы, а также ушные раковины одинакового размера и формы. Только при этих условиях можно корректно воссоздать эффект звучания в вертикальной плоскости и гарантировать правильное определение местоположения источников звука в пространстве. Записи, сделанные с использованием HRTF называются binaural recordings, и они обеспечивают высококачественный 3D звук. Слушать такие записи надо в наушниках, причем желательно в специальных наушниках. Компакт диски с такими записями стоят существенно дороже стандартных музыкальных CD. Чтобы корректно воспроизводить такие записи через колонки необходимо дополнительно использовать технику CC. Но главный недостаток подобного метода - это отсутствие интерактивности. Без дополнительных механизмов, отслеживающих положение головы пользователя, обеспечить интерактивность при использовании HRTF нельзя. Бытует даже поговорка, что использовать HRTF для интерактивного 3D звука, это все равно, что использовать ложку вместо отвертки: инструмент не соответствует задаче.

Sweet Spot

На самом деле значения HRTF можно получить не только с помощью установленных в ушах манекена специальных внутриканальных микрофонов (inter-canal microphones). Используется еще и так называемая искусственная ушная раковина. В этом случае прослушивать записи нужно в специальных внутриканальных (inter-canal) наушниках, которые представляют собой маленькие шишечки, размещаемые в ушном канале, так как искусственная ушная раковина уже перевела всю информацию о позиционировании в волновую форму. Однако нам гораздо удобнее слушать звук в наушниках или через колонки. При этом стоит помнить о том, что при записи через inter-canal микрофоны вокруг них, над ними и под ними происходит искажение звука. Аналогично, при прослушивании звук искажается вокруг головы слушателя. Поэтому и появилось понятие sweet spot, т.е. области, при расположении внутри которой слушатель будет слышать все эффекты, которые он должен слышать. Соответственно, если голова слушателя расположена в таком же положении, как и голова манекена при записи (и на той же высоте), тогда будет получен лучший результат при прослушивании. Во всех остальных случаях будут возникать искажения звука, как между ушами, так и между колонками. Понятно, что необходимость выбора правильного положения при прослушивании, т.е. расположение слушателя в sweet spot, накладывает дополнительные ограничения и создает новые проблемы. Понятно, что чем больше область sweet spot, тем большую свободу действий имеет слушатель. Поэтому разработчики постоянно ищут способы увеличить область действия sweet spot.

Частотная характеристика

Действие HRTF зависит от частоты звука; только звуки со значениями частотных компонентов в пределах от 3 kHz до 10 kHz могут успешно интерпретироваться с помощью функций HRTF. Определение местоположения источников звуков с частотой ниже 1 kHz основывается на определении времени задержки прибытия разных по фазе сигналов до ушей, что дает возможность определить только общее расположение слева/справа источников звука и не помогает пространственному восприятию звучания. Восприятие звука с частотой выше 10 kHz почти полностью зависит от ушной раковины, поэтому далеко не каждый слушатель может различать звуки с такой частотой. Определить местоположение источников звука с частотой от 1 kHz до 3 kHz очень сложно. Число ошибок при определении местоположения источников звука возрастает при снижении разницы между соотношениями амплитуд (чем выше пиковое значение амплитуды звукового сигнала, тем труднее определить местоположение источника). Это означает, что нужно использовать частоту дискретизации (которая должна быть вдвое больше значения частоты звука) соответствующей как минимум 22050 Hz при 16 бит для реальной действенности HRTF. Дискретизация 8 бит не обеспечивает достаточной разницы амплитуд (всего 256 вместо 65536), а частота 11025 Hz не обеспечивает достаточной частотной характеристики (так как при этом максимальная частота звука соответствует 5512 Hz). Итак, чтобы применение HRTF было эффективным, необходимо использовать частоту 22050 Hz при 16 битной дискретизации.

Ушная раковина (Pinna)

Мозг человека анализирует разницу амплитуд, как звука, достигшего внешнего уха, так и разницу амплитуд в слуховом канале после ушной раковины для определения местоположения источника звука. Ушная раковина создает нулевую и пиковую модель звучания между ушами; эта модель совершенно разная в каждом слуховом канале и эта разница между сигналами в ушах представляет собой очень эффективную функциюдля определения, как частоты, так и местоположения источника звука. Но это же явление является причиной того, что с помощью HRTF нельзя создать корректного восприятия звука через колонки, так как по теории ни один из звуков, предназначенный для одного уха не должен быть слышимым вторым ухом.

Мы вновь вернулись к необходимости использования дополнительных алгоритмов CC. Однако, даже при использовании кодирования звука с помощью HRTF источники звука являются неподвижными (хотя при этом амплитуда звука может увеличиваться). Это происходит из-за того, что ушная раковина плохо воспринимает тыловой звук, т.е. когда источники звука находятся за спиной слушателя. Определение местоположения источника звука представляет собой процесс наложения звуковых сигналов с частотой, отфильтрованной головой слушателя и ушными раковинами на мозг с использованием соответствующих координат в пространстве. Так как происходит наложение координат только известных характеристик, т.е. слышимых сигналов, ассоциируемых с визуальным восприятием местоположения источников звука, то с течением времени мозг "записывает" координаты источников звука и в дальнейшем определение их местоположения может происходить лишь на основе слышимых сигналов. Но видим мы только впереди. Соответственно, мозг не может правильно расположить координаты источников звука, расположенных за спиной слушателя при восприятии слышимых сигналов ушной раковиной, так как эта характеристика является неизвестной. В результате, мозг может располагать координаты источников звука совсем не там, где они должны быть. Подобную проблему можно решить только при использовании вспомогательных сигналов, которые бы помогли мозгу правильно располагать в пространстве координаты источников звуков, находящихся за спиной слушателя.

Неподвижные источники звука

Все выше сказанное подвело нас к еще одной проблеме:

Если источники звука неподвижны, они не могут быть точно локализованы, как "статические" при моделировании, т.к. мозгу для определения местоположения источника звука необходимо наличие перемещения (либо самого источника звука, либо подсознательных микро перемещений головы слушателя), которое помогает определить расположение источника звука в геометрическом пространстве. Нет никаких оснований, ожидать, что какая-либо система на базе HRTF функций будет корректно воспроизводить звучание, если один из основных сигналов, используемый для определения местоположения источника звука, отсутствует. Врожденной реакцией человека на неожидаемый звук является повернуть голову в его сторону (за счет движения головы мозг получает дополнительную информацию для локализации в пространстве источника звука). Если сигнал от источника звука не содержит особую частоту, влияющую на разницу между фронтальными и тыловыми HRTF функциями, то такого сигнала для мозга просто не существует; вместо него мозг использует данные из памяти и сопоставляет информацию о местоположении известных источников звука в полусферической области.

Каково же будет решение?

Лучший метод воссоздания настоящего 3D звука это использование минимальной частоты дискретизации 22050 Hz при 16 битах и использования дополнительных тыловых колонок при прослушивании. Такая платформа обеспечит пользователю реалистичное воспроизведение звука за счет воспроизведение через достаточное количество колонок (минимум три) для создания настоящего surround звучания. Преимущество такой конфигурации заключается в том, что когда слушатель поворачивает голову для фокусировки на звуке какого-либо объекта, пространственное расположение источников звука остается неизменным по отношению к окружающей среде, т.е. отсутствует проблема sweet spot.

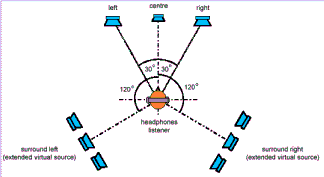

Есть и другой метод, более новый и судить о его эффективности пока сложно. Суть метода, который разработан Sensaura и называется MultiDrive, заключается в использовании HRTF функций на передней и на тыловой паре колонок (и даже больше) с применением алгоритмов CC. На самом деле Sensaura называет свои алгоритмы СС несколько иначе, а именно Transaural Cross-talk cancellation (TCC), заявляя, что они обеспечивают лучшие низкочастотные характеристики звука. Инженеры Sensaura взялись за решение проблемы восприятия звучания от источников звука, которые перемещаются по бокам от слушателя и по оси фронт/тыл. Заметим, что Sensaura для вычисления HRTF функций использует так называемое "цифровое ухо" (Digital Ear) и в их библиотеке уже хранится более 1100 функций. Использование специального цифрового уха должно обеспечивать более точное кодирование звука. Подчеркнем, что Sensaura создает технологии, а использует интерфейс DS3D от Microsoft.

Технология MultiDrive воспроизводит звук с использованием HRTF функций через четыре или более колонок. Каждая пара колонок создает фронтальную и тыловую полусферу соответственно.

Фронтальные и тыловые звуковые поля специальным образом смещены с целью взаимного дополнения друг друга и за счет применения специальных алгоритмов улучшает ощущения фронтального/тылового расположения источников звука. В каждом звуковом поле применяются собственный алгоритм cross-talk cancellation (CC). Исходя из этого, есть все основания предполагать, что вокруг слушателя будет плавное воспроизведение звука от динамично перемещающихся источников и эффективное расположение тыловых виртуальных источников звука. Так как воспроизводимые звуковые поля основаны на применении HRTF функций, каждое из создаваемых sweet spot (мест, с наилучшим восприятием звучания) способствует хорошему восприятию звучания от источников по сторонам от слушателя, а также от движущихся источников по оси фронт/тыл. Благодаря большому углу перекрытия результирующее место с наилучшим восприятием звука (sweet spot) покрывает область с гораздо большей площадью, чем конкурирующие четырех колоночные системы воспроизведения. В результате качество воспроизводимого 3D звука должно существенно повысится.

Если бы не применялись алгоритмы cross-talk cancellation (CC) никакого позиционирования источников звука не происходило бы. Вследствие использования HRTF функций на четырех колонках для технологии MultiDrive необходимо использовать алгоритмы CC для четырех колонок, требующие чудовищных вычислительных ресурсов. Из-за того, что обеспечить работу алгоритмов CC на всех частотах очень сложная задача, в некоторых системах применяются высокочастотные фильтры, которые срезают компоненты высокой частоты. В случае с технологией MultiDrive Sensaura заявляет, что они применяют специальные фильтры собственной разработки, которые позволяют обеспечить позиционирование источников звука, насыщенными высокочастотными компонентами, в тыловой полусфере. Хотя sweet spot должен расшириться и восприятие звука от источников в вертикальной плоскости также улучшается, у такого подхода есть и минусы. Главный минус это необходимость точного позиционирования тыловых колонок относительно фронтальных. В противном случае никакого толка от HRTF на четырех колонках не будет.

Стоит упомянуть и другие инновации Sensaura, а именно технологии ZoomFX и MacroFX, которые призваны улучшить восприятие трехмерного звука. Расскажем о них подробнее, тем более что это того стоит.

MacroFX

Как мы уже говорили выше, большинство измерений HRTF производятся в так называемом дальнем поле (far field), что существенным образом упрощает вычисления. Но при этом, если источники звука располагаются на расстоянии до 1 метра от слушателя, т.е. в ближнем поле (near field), тогда функции HRTF плохо справляются со своей работой. Именно для воспроизведения звука от источников в ближнем поле с помощью HRTF функций и создана технология MacroFX. Идея в том, что алгоритмы MacroFX обеспечивают воспроизведение звуковых эффектов в near-field, в результате можно создать ощущение, что источник звука расположен очень близко к слушателю, так, будто источник звука перемещается от колонок вплотную к голове слушателя, вплоть до шепота внутри уха слушателя. Достигается такой эффект за счет очень точного моделирования распространения звуковой энергии в трехмерном пространстве вокруг головы слушателя из всех позиций в пространстве и преобразование этих данных с помощью высокоэффективного алгоритма. Особое внимание при моделировании уделяется управлению уровнями громкости и модифицированной системе расчета задержек по времени при восприятии ушами человека звуковых волн от одного источника звука (ITD, Interaural Time Delay). Для примера, если источник звука находится примерно посередине между ушами слушателя, то разница по времени при достижении звуковой волны обоих ушей будет минимальна, а вот если источник звука сильно смещен вправо, эта разница будет существенной. Только MacroFX принимает такую разницу во внимание при расчете акустической модели. MacroFX предусматривает 6 зон, где зона 0 (это дистанция удаления) и зона 1 (режим удаления) будут работать точно так же, как работает дистанционная модель DS3D. Другие 4 зоны это и есть near field (ближнее поле), покрывающие левое ухо, правое ухо и пространство внутри головы слушателя.

Этот алгоритм интегрирован в движок Sensaura и управляется DirectSound3D, т.е. является прозрачным для разработчиков приложений, которые теперь могут создавать массу новых эффектов. Например, в авиа симуляторах можно создать эффект, когда пользователь в роли пилота будет слышать переговоры авиа диспетчеров так, как если бы он слышал эти переговоры в наушниках. В играх с боевыми действиями может потребоваться воспроизвести звук пролетающих пуль и ракет очень близко от головы слушателя. Такие эффекты, как писк комара рядом с ухом теперь вполне реальны и доступны. Но самое интересное в том, что если у вас установлена звуковая карта с поддержкой технологии Sensaura и с драйверами, поддерживающими MacroFX, то пользователь получит возможность слышать эффекты MacroFX даже в уже существующих DirectSound3D играх, разумеется, в зависимости от игры эффект будет воспроизводиться лучше или хуже. Зато в игре, созданной с учетом возможности использования MacroFX. Можно добиться очень впечатляющих эффектов.

Поддержка MacroFX будет включена в драйверы для карт, которые поддерживают технологию Sensaura.

ZoomFX

Современные системы воспроизведения позиционируемого 3D звука используют HRTF функции для создания виртуальных источников звука, но эти синтезированные виртуальные источники звука являются точечными. В реальной жизни звук зачастую исходит от больших по размеру источников или от композитных источников, которые могут состоять из нескольких индивидуальных генераторов звука. Большие по размерам и композитные источники звука позволяют использовать более реалистичные звуковые эффекты, по сравнению с возможностями точечных источников звука. Так, точечный источник звука хорошо применим при моделировании звука от большого объекта удаленного на большое расстояние (например, движущийся поезд). Но в реальной жизни, как только поезд приближается к слушателю, он перестает быть точечным источником звука. Однако в модели DS3D поезд все равно представляется, как точечный источник звука, а значит, страдает реализм воспроизводимого звука (т.е. мы слышим звук скорее от маленького поезда, нежели от огромного состава громыхающего рядом). Технология ZoomFX решает эту проблему, а также вносит представление о большом объекте, например поезде как собрание нескольких источников звука (композитный источник, состоящий из шума колес, шума двигателя, шума сцепок вагонов и т.д.).

Для технологии ZoomFX будет создано расширение для DirectSound3D, подобно EAX, с помощью которого разработчики игр смогут воспроизводить новые звуковые эффекты и использовать такой параметр источника звука, как размер. Пока эта технология находится на стадии завершения.

Компания Creative реализовала аналогичный подход, как в MultiDrive от Sensaura, в своей технологии CMSS (Creative Multispeaker Surround Sound) для серии своих карт SB Live!. Поддержка этой версии технологии CMSS, с реализацией HRTF и CC на четырех колонках, встроена в программу обновления LiveWare 2.x. По своей сути, технология CMSS является близнецом MultiDrive, хотя на уровне алгоритмов CC и библиотек HRTF наверняка есть отличия. Главный недостаток CMSS такой же, как у MultiDrive - необходимость расположения тыловых колонок в строго определенном месте, а точнее параллельно фронтальным колонкам. В результате возникает ограничение, которое может не устроить многих пользователей. Не секрет, что место для фронтальных колонок давно зарезервировано около монитора. Место для сабвуфера можно выбрать любым, обычно это где-то в углу и на полу. А вот тыловые колонки пользователи располагают там, где считают удобным для себя. Не каждый захочет расположить их строго за спиной и далеко не у всех есть свободное место для такого расположения.

Заметим, что главный конкурент Creative на рынке 3D звука, компания Aureal, использует технику панорамирования на тыловых колонках. Объясняется это именно отсутствием строгих ограничений на расположение тыловых колонок в пространстве.

Не стоит забывать и о больших объемах вычислений при расчете HRTF и Cross-talk Cancellation для четырех колонок

Еще один игрок на рынке 3D звука - компания QSound пока имеет сильные позиции только в области воспроизведения звука через наушники и две колонки. При этом свои алгоритмы для воспроизведения 3D звука через две колонки и наушники (в основе лежат HRTF) QSound создает исходя из результатов тестирования при прослушивании реальными людьми, т.е. не довольствуется математикой, а делает упор на восприятие звука конкретными людьми. И таких прослушиваний было проведено более 550000! Для воспроизведения звука через четыре колонки QSound использует панорамирование, т.е. тоже, что было в первой версии CMSS. Такая техника плохо показала себя в играх, обеспечивая слабое позиционирование источников звука в вертикальной плоскости.

Компания Aureal привнесла в технологии воспроизведения 3D звука свою технику Wavetracing. Мы уже писали об этой технологии, вкратце, это расчет распространения отраженных и прошедших через препятствия звуковых волн на основе геометрии среды. При этом обеспечивается полный динамизм восприятия звука, т.е. полная интерактивность.

Итак, подведем итоги. Однозначный вывод состоит в том, что если вы хотите получить наилучшее качество 3D звука, доступное на сегодняшний день, вам придется использовать звуковые карты, поддерживающие воспроизведение минимум через четыре колонки. Использование только двух фронтальных колонок - это конфигурация вчерашнего дня. Далее, если вы только собираетесь переходить на карты с поддержкой четырех и более колонок, то перед вами встает классическая проблема выбора. Как всегда единственная рекомендация состоит в том, чтобы вы основывали свой выбор на собственных ощущениях. Послушайте максимально возможно число разных систем и сделайте именно свой выбор.

Теперь посмотрим, с каким багажом подошли ведущие игроки 3D звукового рынка к сегодняшнему дню и что нас ждет в ближайшем будущем.

EAR

EAR - в текущей версии IAS 1.0 реализована поддержка воспроизведения DS3D, A3D 1.0 и EAX 1.0 через четыре и более колонок. За счет воспроизведения через четыре и более колонок, мозг слушателя получает дополнительные сигналы для правильного определения местоположения источников звука в пространстве.

Осенью ожидается выход IAS 2.0 с поддержкой DirectMusic, YellowBook, EAX 2.0

и A3D 2.0, force-feed back (мы сможем чувствовать звук, а именно давление звука, громкость и т.д.), декодирование в реальном времени MP3 и Dolby/DTS, будет реализована поддержка ".1" канала (сабвуфера). Кроме того, в IAS 2.0 будет реализовано звуковое решение, не требующее наличие звуковой карты (cardless audio solution) для использования с полностью цифровой системой воспроизведения звука, например с USB колонками или в тандеме с домашней системой Dolby Digital.

Главные достоинства IAS от EAR:

· Один интерфейс для любой многоколоночной платформы, обеспечивающий одинаковый результат вне зависимости от того, как воспроизводится звук при использовании специального API.

· Имеется поддержка воспроизведения через две колонки (для старых систем),

если многоколоночная конфигурация недоступна.

· Пользователь может подключить свой компьютер к домашней звуковой системе (Dolby Digital и т.д.) и IAS будет воспроизводить звук без необходимости какой-либо модернизации.

Итак, по сравнению с конкурентами, IAS работает на любой платформе и не

требует специального аппаратного обеспечения. При этом IAS использует любое доступное аппаратное обеспечение и обеспечивает пользователю наилучшее качество звука, которое доступно на его системе. Только вот остановит ли свой выбор пользователь на этой технологии, это большой вопрос. С другой стороны, для использования IAS не нужно покупать специальных звуковых карт.

Sensaura

Sensaura - компания занимающаяся созданием технологий. Производители звуковых чипов лицензируют разработки Sensaura и воплощают их в жизнь. В чипе Canyon3D от ESS будет реализована поддержка современных технологий Sensaura, которые должны обеспечить слушателем 3D звук на современном уровне, т.е. позиционируемый в пространстве и с воспроизведением через четыре и более колонок. За воспроизведение через четыре и более колонок отвечает технология MultiDrive, которая реализует HRTF и алгоритмы Cross-talk cancellation. Многообещающе выглядят технологии ZoomFX и MacroFX. Кроме того, Sensaura поддерживает воспроизведение реверберации через EAX от Creative, равно как и через I3DL2, а также эмулирует поддержку A3D 1.х через DS3D.

Первым звуковым чипов, который реализует технологию MultiDrive на практике, является Canyon3D от ESS Technology, Inc. Более подробную информацию о чипе Canyon3D можно найти на официальном сайте www.canyon3d.com.

Первая карта на базе чипа Canyon3D называется DMX и производит ее компания Terratec.

Как только эта карта попадет к нам на испытания, мы представим на ваш суд обзор. Заметим только, что на этой карте будут сразу оба типа цифровых выходов S/PDIF коаксиальный (RCA) и оптический (Toslink), и один цифровой вход. Так что продукт обещает быть очень интересным.

Creative

Creative - занимается совершенствованием своего движка реверберации. В итоге в свет выйдет EAX 3.0, который должен добавить больше реализма в воспроизводимый звук. Никто не спорит, что реверберация это хорошо, что именно она обеспечивает насыщенное и живое звучание. При этом Creative упорно не собирается вести разработки в области геометрии акустики. Кстати, Microsoft объявила о намерении включить EAX в состав DirectSound3D 8.0. С другой стороны, есть неподтвержденные слухи, что EAX 3.0 будет закрытым стандартом. Интересно, изменит ли Creative свою позицию со временем? Пока же в новых версиях EAX нам обещают больше реализма и гибкости в настройках реверберации и моделировании звуковой среды для конкретных объектов и помещений, плюс плавные переходы от одной заранее созданной звуковой среды к другой при движении слушателя в 3D мире. Будут улучшения в области воспроизведения эффектов окклюзии и обструкции. Обещают и поддержку отраженных звуков, но без учета геометрии и более продвинутую дистанционную модель. Вообще, я не удивлюсь, если Creative лицензирует MacroFX и ZoomFX у Sensaura. Что касается моделирования звука на основе физической геометрии среды, то Creative очень усиленно отрицает для себя возможность поддержки такого метода. Хотя, если поднять архивы и посмотреть первый пресс-релиз о будущем чипе Emu10k1, то вы будете удивлены. Там говорится именно об использовании физической геометрии среды при моделировании звука. Потом планы изменились. Кто помешает Creative вновь изменить планы? Особенно если учесть появление в ближайшее время движка реверберации от Aureal. Вряд ли Creative не сделает ответного хода.

QSound

QSound ведет работы по созданию новой технологии воспроизведения 3D звука через четыре и более колонок. Зная пристрастия QSound, можно предположить, что в основу новой технологии опять лягут результаты реальных прослушиваний. QSound, как и Sensaura занимается именно технологиями, которые воплощают в виде чипов другие компании. Так, чип Thunderbird128 от VLSI воплощает в себе все последние достижения QSound в области 3D звука, при этом Thunderbird128 это DSP, а значит, есть все основания ожидать последующей модернизации. Стоит упомянуть, что QSound, подобно Creative считает, что главное в 3D звуке это восприятие слушателем окружающей атмосферы игры. Поэтому QEM (QSound Environmental Modeling) совместима с EAX 1.0 от Creative. Следует ожидать, что QEM 2.0 будет совместима с EAX 2.0. Отметим, что QSound славится очень эффективными алгоритмами и грамотным распределением доступных ресурсов, неслучайно именно их менеджер ресурсов был лицензирован Microsoft и включен в DirectX.

Aureal

С Aureal все более-менее понятно. В ближайшем будущем нам обещают дальнейшее улучшение функциональности A3D, мощный движок реверберации, поддержку HRTF на четырех и более колонках.

Мы упомянули основные разработки в области 3D звука, которые применяются в компьютерном мире. Есть еще ряд фирм с интересными решениями, но они делают упор на рынок бытовой электроники, поэтому в данном материале yt рассказывается о них.

Обзорно изучив технологии, существующие на рынке позиционирования 3Д звука, попробуем рассмотреть их более пристально.

В видении компании Sensaura

Компания Sensaura более 10 лет занимается созданием звуковых технологий. Все разработки Sensaura ориентированы на работу через стандартный интерфейс DirectSound3D и его расширения. Часть технологий Sensaura уже применяются на практике, другие разработки мы скоро увидим в действие. По сути, Sensaura предлагает использовать производителям звуковых чипов и карт специальные алгоритмы, которые в паре со стандартным API DS3D и расширениями для него, должны обеспечить моделирование и воспроизведение качественного 3D звука.

Попробуем рассказать о том, что же предлагает Sensaura.

Digital Ear

Для корректного воспроизведения 3D звука через наушники или колонки необходимо использовать специальные алгоритмы, базирующиеся на использовании HRTF функций. Кроме того, при воспроизведении 3D звука через колонки необходимо использовать дополнительные алгоритмы Cross-talk Cancellation, вариант которых от Sensaura носит имя Transaural Cross-talk Cancellation (TCC).

Инженеры Sensaura пришли к выводу, что использование для формирования библиотек HRTF измерения, сделанные с помощью специального манекена или с приглашением реальных слушателей не могут обеспечить удовлетворить абсолютно всех слушателей. Дело в том, что какое бы большое число измерений не было сделано с использованием манекена, все полученные HRTF все равно будут усредненными. Все то же самое относится и к измерениям, сделанным с приглашением большого числа различных слушателей. Все равно есть небольшая часть людей, у которых совершенно отличные параметры слуха, а значит, при измерении у них получаются, совсем другие HRTF функции. В результате, какой бы большой и универсальной не была библиотека HRTF функций, часть людей не услышат ожидаемого 3D звука. Чтобы решить эту проблему, специалисты Sensaura разработали технологию Digital Ear (Цифровое ухо), ранее называвшуюся Virtual Ear. Суть идеи Digital Ear в том, что для измерения HRTF используется не просто манекен или приглашаются реальные слушатели, а используется чисто математический метод Ключевым элементом этого метода является математическая модель человеческого уха с изменяемыми параметрами. В основу математической модели положена концепция того, что сложные резонансные и дифракционные эффекты, являющиеся неотъемлемой частью любой HRTF функции могут независимо изменяться. В результате созданая дуплексная система, позволяющая изменять различные параметры в произвольном масштабе. Прежде чем была построена эта математическая модель было проведено масса исследований с целью точно смоделировать само ухо, точно определить, как оно реагирует на звуковые волны и как работает процесс человеческого слуха. Учитывались особенности восприятия мозгом различных звуков от источников, расположенных в разных точках пространства. Затем была создана модель уха из специального пластика, на нем были проведены измерения и отлажена математическая модель. Потом были получены базовые результаты измерения HRTF, на основе которых в дальнейшем с помощью специальных методов масштабирования стала формироваться библиотека HRTF. Использование математической модели гарантирует от наличия ошибок, которые возможны при физическом измерении HRTF с помощью манекена или реальных слушателей. Digital Ear можно настроить на огромное количество вариаций форм и размеров ушей реальных людей. В итоге получается обширная библиотека с возможностью очень гибко выбрать одну или несколько HRTF, которая наилучшим образом соответствует особенностям каждого конкретного слушателя. Кроме того, так как используется математическая модель, имеется возможность довольно простой модернизации алгоритмов и обновления библиотек HRTF без больших материальных затрат.

Между некоторыми параметрами Digital Ear существует зависимость, не мешающая масштабированию каждого из параметров в отдельности. Это позволяет построить простой интерфейс пользователя, позволяющий путем определения и задания в качестве данных некоторых физических параметров, описывающих голову и уши слушателя выбрать именно те HRTF функции из библиотеки, которые наилучшим образом отвечают особенностям конкретного слушателя. Вот эти параметры:

· Размер головы (Head Size) - влияет на изменение величины ITD (Interaural time delay) задержки по времени при восприятии ушами слушателя звука от одного источника

· Размер уха (Ear Size) - влияет на протяженность звукового спектра

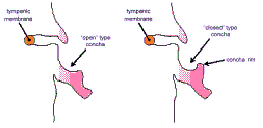

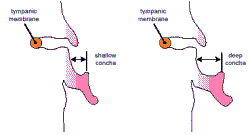

· Глубина ушной раковины (Concha Depth) - влияет на величину сдвига звукового спектра

· Тип ушной раковины (Concha Type) - влияет на величину амплитуды звукового сигнала

Слева неглубокая ушная раковина, справа – глубокая

Слева ушная раковина открытого типа, справа - закрытого типа

В результате, каждый пользователь сможет настроить воспроизведения 3D звука с использованием технологии Digital Ear специально под себя. Пока технология Digital Ear не позволяет использовать гибкую настройку под конкретного слушателя и во всех дравейрах к звуковым картам, использующим технологии Sensaura задействуется универсальный набор HRTF функций, соответствующий среднему слушателю. Однако обещается, что уже в скором времени у пользователя появится возможность выбора HRTF под себя.

Смоделированный 3D звук мы можем слушать через наушники или через набор акустических колонок. При прослушивании через наушники используются только HRTF функции для воспроизведения эффектов 3D звука. Эта техника является традиционной и пока кардинально нового тут ничего не предвидится. За исключением шлифовки качества HRTF и предоставления пользователю возможности выбора HRTF конкретно под себя. При воспроизведении звука через две колонки также используется довольно традиционный метод комбинирования HRTF и алгоритмов cross-talk cancellation. Зато при вопсроизведении 3D звука через четыре и более колонок пока нет единого метода. Компания Sensaura разработала технологию MultiDrive, которая обеспечивает воспроизведение 3D звука с помощью более чем четырех колонок.

MultiDrive

Прежде всего начнем немного издалека. Зададимся вопросом, а зачем нам собственно слушать 3D звук через более чем одну пару колонок? Ну, в пользу мультиколоночных акустических систем можно сказать, что, во-первых у некоторых пользователей они уже есть, так почему бы их не использовать. Во-вторых, обычная ситема из двух колонок с использованием HRTF + CC имеет ряд ограничений при вопроизведении звуков от источников, расположенных в вертикальной плоскости и при движении источника звука по оси фронт/тыл. Итак, понятно, что, как минимум дополнительная пара колонок на тылах нам не повредит.

Есть и еще один момент. При использовании связки HRTF + CC могут возникнуть сложности корректного воспроизведения некоторых высокочастотных компонет звука выше величины в несколько kHz. Например, если на фоне звука взрывов нужно воспроизвести пение птахи. Причиной этого является невозможность реализовать идеально алгоритмы CC. Разные компании по разному борятся с этой проблемой, например, используются специальные фильтры высокой частоты, которые просто вырезают высокочастотные компоненты. В технологии MultiDrive применяются специальные фильтры, которые позволяют обеспечить воспроизведение звука, насыщенного высокочастотными компонентами.

Кроме того, для наилучшего восприятия звука слушатель должен находится в границах sweet spot, т.е. участка пространства, в котором звук воспринимается наилучшим образом. Понятно, что чем больше площадь sweet spot, тем большая свобода у слушателя. Мы ведь не манекены и не можем долгое время сидеть, не меняя положения головы относительно пола. В настоящее время наиболее распространена конфигурация из 4 колонок (не считая сабвуфера), поэтому в дальнейшем мы будем говорить именно о такой конфигурации акустики.

Технология MultiDrive позволяет воспроизводить 3D звук с использованием API DS3D. Суть этой технологии заключается в использовании HRTF функций на всех парах колонок с применением алгоритмов Transaural Cross-talk Cancellation (TCC). Отличие TCC от стандартных алгоритмов CC заключается в том, что они обеспечивают лучшие низкочастотные характеристики звука. Кроме того, предусмотрена возможность для пользователя управлять работой TCC, настраивая звучание под себя.

Каждая пара колонок создает фронтальную и тыловую полусферу соответственно. Фронтальные и тыловые звуковые поля специальным образом смещены с целью взаимного дополнения друг друга и за счет применения специальных алгоритмов улучшает ощущения фронтального/тылового расположения источников звука и под управлением DS3D. В каждом звуковом поле применяются собственный алгоритм TCC. Исходя из этого, вокруг слушателя должно происходить плавное воспроизведение звука от динамично перемещающихся источников и эффективное расположение тыловых виртуальных источников звука. Благодаря большому углу перекрытия результирующее место с наилучшим восприятием звука (sweet spot) покрывает область с гораздо большей площадью, по сравнению, например, с двухколоночной конфигурацией.

Минусом использования HRTF + TCC на всех парах колонок является то, что для расчета TCC требуется масса вычислительных ресурсов и необходимость довольно точного позиционирования тыловых колонок относительно фронтальных. В противном случае никакого толка от HRTF + TCC на четырех колонках не будет.

Стоит добавить, что MultiDrive рассчитана на совместное использование с алгоритмами MacroFX и ZoomFX от Sensaura.

MacroFX

Мы уже говорили выше, что с помощью HRTF и TCC можно воспроизвести качественный 3D звук. Но есть один нюанс. Обычно большинство измерений HRTF производятся в так называемом дальнем поле (far field, на дистации более 1 метра до источника звука), т.к. это существенно упрощает вычисления да и в большинстве игр воспроизводится звук от источников, находящихся на расстоянии от 1 метра и больше от слушателя. При этом, если источник звука находится на расстоянии до 1 метра от слушателя, т.е. в ближнем поле (near field), тогда эффективность использования HRTF снижается. Дело в том, что для создания звучания от удаленного источника звука достаточно добавить к основному звуковому сигналу реверберацию. Иногда можно обойтись и без реверберации, сократив высокочастотные компоненты в основном звуковом сигнале. Если источник звука находится в ближнем поле, подобные решения не применимы. Но необходимость в воспроизведении звука от источников в ближнем боле нередки. Например, в игре типа RPG может возникнуть необходимость нашептать подсказку непосредственно в ухо игроку, а в FPS игре часто необходимо воспроизвести звук пролетающих рядом с головой игрока пуль. Все эти эффекты нельзя вопроизвести, если HRTF измерялись на дистанции от одного метра и более, т.е. в дальнем поле. Тем не менее, измерить HRTF для всей области ближнего поля очень сложно, а использование дискретных наборов HRTF, сделанных, например, для дистанций 1 м, 0.9 м, 0.9 м и т.д. не позволит сделать звук от движущегося объекта естественно плавным, он будет скачкообразным. Решением проблемы является использование единого набора универсальных HRTF для ближнего поля с использованием дополнительного алгоритма.

Этот алгоритм был создан Sensaura и получил имя MacroFX. В результате работы MacroFX можно создать ощущение, что источник звука расположен очень близко к слушателю, так, будто источник звука перемещается от колонок вплотную к голове слушателя и вплоть до шепота внутри уха слушателя. Достигается такой эффект за счет очень точного моделирования распространения звуковой энергии в трехмерном пространстве вокруг головы слушателя, преобразования этих данных в тесном взаимодействии с HRTF функциями. Особое внимание при моделировании уделяется управлению уровнями громкости и модифицированной системе расчета задержек по времени при восприятии ушами человека звуковых волн от одного источника звука (ITD, Interaural Time Delay). Для примера, если источник звука находится примерно посередине между ушами слушателя, то разница по времени при достижении звуковой волны обоих ушей будет минимальна, а вот если источник звука сильно смещен вправо, эта разница будет существенной. Только MacroFX принимает такую разницу во внимание при расчете акустической модели. Все эти вычисления происходят до начала работы алгоритмов TCC, но сразу после расчета HRTF для всех источников звука.

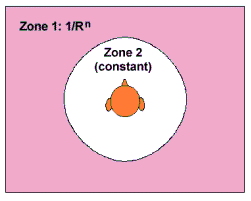

В DS3D предусмотрено три зоны (две из них показаны на рисунке слева). Зона 0 в ней располагаются сильно удаленные источники звука, которые имеют постоянную интенсивность, не зависящую от расстояния. Источники в этой зоне могут не приниматься во внимание, т.е. слушатель их не слышит, либо они используются для формирования реверберации. Зона 1 это т.н. дальнее поле, в ней располагаются источники на расстоянии более 1 метра от слушателя и до определяемой разработчиком границы. В этой зоне интенсивность источников звука обратно пропорциональна расстоянию до слушателя. В зоне 2 (ближнее поле, расстояние до 1 м от слушателя) все источники звука имеют постоянную интенсивность. Это сделано для того, чтобы уровень громкости не превысил допустимого барьера и с целью ограничения нагрузки на шину данных.

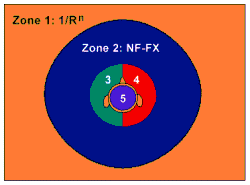

MacroFX предусматривает 6 зон, где зона 0 (это дистанция удаления) и зона 1 (дальнее поле) будут работать точно так же, как работает дистанционная модель DS3D. Другие 4 зоны это и есть near field (ближнее поле) в стиле MacroFX, покрывающие дистанцию рядом с головой слушателя, левое ухо, правое ухо и пространство внутри головы слушателя. При этом здесь также вводятся ограничение на дистанцию, чтобы сократить накладные расходы при вычислениях. Поэтому в зоне 2 используется стандартный алгоритм Near-Field FX, а в зонах 3, 4 и 5, которые начинают работать с расстояния в 20 см, используется как таковой алгоритм MacroFX. Эти три зоны рассчитаны на источники звука, расположенные очень близко к ушам пользователя (левому или правому). Если источник звука должен находится как бы в голове пользователя (например, переговоры авиадиспетчеров в авиасимуляторе), то для этого используется зона 5.

Алгоритм MacroFX полностью прозрачен для интерфейсов и игр. Это означает, что если у вас установлена звуковая карта, в драйвер которой встроена поддержка MacroFX, то вы услышите работу этой технологии во всех играх, где источники звука попадают в ближнее поле. Разумеется, в зависимости от конкретной игры эффект будет воспроизводиться лучше или хуже. Зато в игре, созданной с учетом возможности использования MacroFX можно добиться очень впечатляющих эффектов, например, писк комара прямо в ухе, свист ветра в ушах при езде на велосипеде и т.д.

ZoomFX

Современные системы воспроизведения позиционируемого 3D звука используют HRTF функции для создания виртуальных источников звука, являющихся точечными. В реальной жизни звук зачастую исходит от больших по размеру источников звука или от композитных источников, объединяющих собой сразу несколько источников звука. Большие по размерам и композитные источники звука позволяют использовать более реалистичные звуковые эффекты, по сравнению с возможностями точечных источников звука. Так, точечный источник звука хорошо применим при моделировании звука от большого объекта удаленного на большое расстояние (например, движущийся поезд). Но в реальной жизни, как только поезд приближается к слушателю, он перестает быть точечным источником звука. В реальной жизни, когда поезд проезжает рядом с нами, мы слышим стук колес, скрип рессор, звук от буферов и т.д. Тем не менее, при моделировании источника звука типа поезд с использованием интерфейса DS3D поезд представляется, как точечный источник звука. В результате звук получается ненатуральным, т.е. мы слышим звук скорее от маленького поезда, нежели от огромного состава громыхающего рядом. Технология ZoomFX решает эту проблему, за счет введения такого параметра источника звука, как размер и сложность. Если вспомнить про наш поезд, то он будет представлен в виде собрания нескольких источников звука, типа шума колес, шума двигателя, шума сцепок вагонов и т.д. Для представления большого по размеру объекта используется набор из нескольких точечных источников звука. Для того чтобы мы слышали отдельные составляющие композитного источника звука используется метод динамической декорреляции (Dynamic Decorrelation), позволяющий выделить отдельные источники, составляющие композитный источник звука.

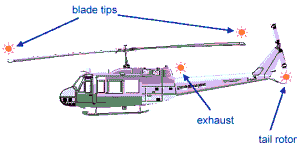

На рисунке показано, как источник звука типа вертолет представляется в виде нескольких точеных источников. Когда вертолет далеко от нас, все четыре точечных источника формируют единый звуковой сигнал в виде гула. Этот основной звук можно снабдить дополнительными звуковыми сигналами в виде реверберации, чтобы пользователю было проще определить источник звука. Например, что вертолет летит на расстоянии 50 метров на фоне высотного здания из стеклобетона. Как только вертолет приблизится на достаточное расстояние к нам, так, что мы сможем легко его рассмотреть вполне логично ожидать, что мы сможем выделить звук от лопастей (как они рассекают воздух), звук от турбины и звук от хвостового винта. Именно для таких целей и предназначен ZoomFX. На практике все работает следующим образом. В качестве носителя звука вертолета может выступать обычный монофонический wav файл. Затем, когда возникает необходимость выделить составляющие источники звука, начинает работать динамический декоррелятор, который выделяет несколько вторичных звуков, которые затем подвергаются обработке HRTF фильтрами, затем происходит сложение соответствующих каналов (правые с правыми, левы с левыми и т.д.), затем сигнал обрабатывается алгоритмами TCC и воспроизводится через акустическую систему. К слову, возможность создания нескольких виртуальных источников звука с помощью ZoomFX может быть использована, например, для воспроизведения в наушниках многоканального звука типа Dolby Digital.

Технология ZoomFX в отличие от MacroFX не является прозрачной для интерфейсов и игр. Для ее поддержки будет создано расширение для DirectSound3D, подобно EAX, с помощью которого разработчики игр смогут воспроизводить новые звуковые эффекты и использовать такой параметр источника звука, как размер. Пока эта технология находится на стадии завершения.

EnvironmentFX

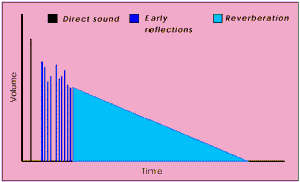

Технология EnvironmentFX создана для моделирования звука окружающей среды и рассчитана на использование со стандартными интерфейсам типа EAX и I3DL2. По сути, технология EnvironmentFX позволяет воспроизводить эффект реверберации, описывая то, как звуки достигают ушей слушателя в зависимости от параметров помещения. Помещением может быть и открытое пространство и маленькая келья монаха. Когда слушатель находится в помещении с истоником звука он сначала слышит звук, достигший его ушей по прямому пути, затем, чуть поздее, он сылшит ранние отражения (звуки несколько раз отразившиееся от стен или объектов) и в самый последний момент он слышит реверберацию, т.е. поле остаточных отраженных звуков, затухающее со временем.

На иллюстрации слева показано распределение звуковых сигналов в зависимоти от уровня громкости и продолжительности во времени.

EnvironmentFX позволяет моделировать различные типы акустики за счет использования специальных алгоритмов, рассчитывающих ранние отражения и реверберацию. При этом истоник каждого из ранних отраженных звуков может позиционироваться индивидуально в 3D пространстве. Для того, чтобы переходы между различными помещениями (читай разными аустическими средами) были плавными и естественными предусмотрены специальные фильтры, причем алгоритм EnvironmentFX динамически переконфигурируется переключаясь на нужный. Имеется возможность динамического регулирования уровня интенсивности реверберации для каждого источника звука индивидуально. EnvironmentFX специально ориентирована на воспроизведение через мультиколоночную конфигурацию акустики с использованием технологии MultiDrive, но при этом допускается воспроизведение звука и через две колонки или наушники. Для моделирования различных акустических сред EnvironmentFX использует параметры самого истоника звука (интенсивность, расположение в пространстве) и параметры окружающей среды. Для воспроизведения звука вокруг пользователя EnvironmentFX использует следующие характеристики:

· Direct-to-reverberant sound ratio - соотношение уровней громкости основных звуков и реверберации. Уровень громкости основного звука становится интенсивнее при достижении ушей слушателя и становится тише, когда уходит на задний план. В тоже время уровень громкости реверберации приблизительно неизменен вне зависимости от расстояния между слушателем и источником звука. Сооношение уровней громкости основного звука и реверберации дает слушателю важную информацию для оценки расстояния до истоника звука.

· Room size - размеры помещения. В маленьком помещении, например холле, расстояние между отраженными звуковыми волнами мало, т.е. отраженные звуки близки друг к другу и довольно быстро формируют остаточную реверберацию. В большом помещении, например ангаре для самолетов, наоборот, отраженные волны преодолевают большие расстояния и для формирования реверберации требуется больше времени.

· High-frequency cut-off - отбрасывание высокочастотных компонент звука. Когда материал стен или объхектов отражает звук, не все частотные компоненты отражаются с одинаковой степенью. Большинство материалов поглащают частоты определенного значения, т.е отбрасывается часть высокочастотных компонент. Например в ванной комнате отражаются звуки с частотой вплоть до 14000 Гц, а вгостинной комнате с коврами на стенах отбрасываются все компоненты с частотой более 2000 Гц.

· Early reflection level - уровень интенсивности ранних отражений. Ранние отражения дают возможность пользователю определить наличие близких объектов и стен. Чем больше предметов и стен находится близко к пользователю тем большим будет процент ранних отражений в общей звуковой картине. Например, близкорасположенные стены из кирпича в коридоре формируют большое количество ранних отражений,а открытое трявяное поле не формирует ни одного раннего отраженного звука.

· Reverberation level - уровень интенсивности реверберации. Уровень громкости реверберации может варьироваться при смене одного помещения на другое.

· Reverberation decay time - время затухания реверберации. Это время, необходимое для того, чтобы реверберация была полностью поглощена воздухом и стенами в помещении. Например, в большом ангаре со звукоотражающими стенами время реверберации порядка 10 секунд, в палате со стенами из войлока очень хорошо поглощающих звук, время затухания реверберации около 0.2 секунды.

· High Frequency decay time - время затухания высокочастотных компонент звука. Время затухания высокочастотных компонент напрямую завист от свойств окружающих объектов и стен. Например мрамор хорошо отражает высокочастотные звуки, а под водой высокочастотные компоненты очень быстро затухают.

· Density - плотность. Плотность отраженных звуков зависит от числа объектов, от которых отражается звук. Чем выше плотность, тем быстрее отраженные звуки переходят в реверберацию. Закрытая комната со звукоотражающими стенами имеет очень высокую плотность отражений, по сравнению с открытым полем.

· Diffusion - рассеивание. Величина, показывающая с какой степенью звуковые волны совмещаются или разделяются при соприкосновении с поверхностями в помещении. Комната с разнообразными по форме объектами созадает высокую степень диффузии звука, чем простот пустая комната с голыми стенами. Многие концертные залы имеют такую форму, что возникает диффузная реверберация.

· Detuning - расстройка. Расстройка может использоваться для симуляции изменения тональности звука, которая возникает при отражении звука от движущихся поверхностей. Может изменяться как величина, так и глубина расстройки. Применяется, например, для симуляции плеска волн на ветру.

Нетрудно заметить, что хотя мы рассмотрели технологию EnvironmentFX самой последней в статье, она, несомненно самая важная из применяемых на практике разработок Sensaura.

В видении компании Aureal (Wavetracing)

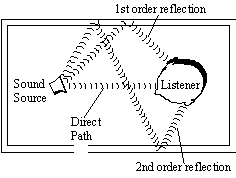

Для создания полного ощущения погружения в игру, необходимо рассчитать акустическую среду окружения и ее взаимодействие с источниками звука. По мере распространения звуковой волны, она ослабляется, т.е. находится под воздействием среды, в которой она распространяется. При распространении звуковые волны достигают слушателя различными путями:

· Они могут следовать по прямому пути к слушателю (direct path).

· Один раз отразившись от объекта (путь первого отраженного звука -- first order reflected path).

· Отраженный дважды (путь вторично отраженного звука -- second order reflected path) и более раз.

· Звуки могут так же проходить сквозь объекты, такие, как вода или стены (occlusions или звук, прошедший сквозь препятствие).

Алгоритмы обсчета путей распространения звуковых волн (wavetracing) компании Aureal воспроизводят эффект распространения звука в окружающей среде; причем это немалая работа с любой точки зрения. В документации с сайта Aureal алгоритмы wavetracing описываются так:

Технология Wavetracing компании Aureal анализирует геометрию описывающую трехмерное пространство для определения путей распространения звуковых волн в режиме реального времени, после того, как они отражаются и проходят сквозь пассивные акустические объекты в трехмерной окружающей среде.

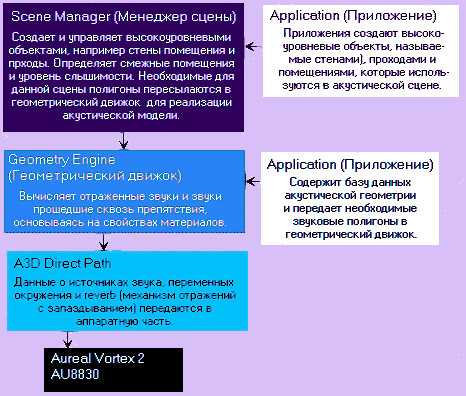

Существуют три главных компонента: интерфейс A3D, geometry engine (геометрический движок, определяющий геометрию объектов в пространстве) и scene manager (менеджер сцены). Интерфейс A3D является основным компонентом. Один в отдельности он используется для реализации прямых путей распространения звука (direct path). Geometry engine является основным компонетом для обсчета отраженных и прошедших сквозь препятсвия акустических звуковых волн или для Acoustic Wavetracing. Менеджер сцены используется как геометрическим движком, так и интерфейсом A3D для управления сложными звуковыми сценами. Обработка каждого из этих компонетов будет производиться именно в таком порядке.

Взаимосвязь и функционирование менеджера сцены, геометрического движка и реализация прямых путей распространения звука показаны ниже:

Прямые пути распространения A3D звука

Реализация прямых путей распространения A3D звука содержит 4 компонента: источник звука (Sound source), окружающая среда, в которой распространяется звук, слушатель (или приемное устройство) и отраженный звук с запаздыванием (late reflections).

Источник звука (Sound source)

Источник звука описывается на основе информации о его местоположении, направленности и угла конуса (угол между лучем слышимости и границей звука, распространяемого источником). Если источник звука динамичен, т.е. движется, то применяются дистанционная и допплеровская модели. Для эффективного распределения ресурсов, источники звука располагаются в соответствии с приоритетом.

Дистанционная модель: В дистанционной модели определяется масштабный коэффициент, который контролирует эффективность увеличения количества источников звука на расстоянии. В результате определяется минимальная дистанция для начала увеличения количества источников звука и максимальное расстояние, на котором этот процесс прекращается.

Допплеровская (Doppler) модель: В этой модели определяется скорость распространения звука, высота звука и масштабы применения эффекта Допплера (эффект Допплера заключается в том, что при движении источника волны относительно приемника изменяется длина волны. При приближении источника звука к приемнику длина волны уменьшается, а при удалении растет на величину, определяемую по специальной формуле).

Слушатель

Слушатель определяется свойствами, включающими местоположение, направленность и скорость перемещения.

Окружающая среда

Окружающая среда представляет вещество, окружающее распространяющийся звук. После начала распространения звуковой волны, она начинает проходить через окружающую среду, в которой с волной могут происходить разные вещи: она поглощается воздухом, причем степень поглощения зависит от частоты волны, наличия ветра (т.е. движения воздуха) и влажности воздуха.

В интерфейсе A3D 2.0 окружающая среда определяется свойствами и задается особым образом, описанным ниже. Эти переменные окружающей среды вероятно будут применяться ко всем источникам звука внутри сцены. С аппаратной точки зрения, чипсет Vortex 2 объединяет атмосферные фильтры внутри своего блока реализации A3D звука. По всей вероятности, ввод данных, основанных на переменных окружающей среды осуществляется с применением фильтров, которые должны имитировать различные изменения звука во время прохождения через разные атмосферные среды.

Свойства окружающей среды A3D звука

Заранее задаваемые свойства окружающей среды:

· Воздух и вода.

· Скорость распространения звука.

· Высчокочастотное затухание, зависящее от окружающей среды.

· Степень затухания звукового сигнала с увеличением расстояния от источника до приемника.

Звук, отраженный с запаздыванием (Late Reflections)

Использование отраженного звука предоставляет способ точно определить местоположение источников звука, а так же размер, форму и тип помещения или окружающей среды, в который мы находимся. Чипсет Vortex 2 имеет возможность оперировать до 64 трехмерными источниками отраженного звука. Это осуществляется благодяря использованию геометрического движка, который моделирует ранние отраженные звуки. Ранние отраженные звуки (early reflections) относятся к звукам, отраженным в первую очередь.

Запаздывающий отраженный (late order reflections) звуковой сигнал воспринимается как эхо или реверберация (reverberation). Вот разумное объяснение этому: человек имеет возможность индивидуально воспринимать первый отраженный звук, в то время как второй и все последующие отраженные звуки обычно смешиваются в форму поля запаздывающих отраженнных звуковых сигналов или просто эхо.

Лучше всего эхо проявляется на очень больших пространствах, когда требуется большое время для затухания сигнала. Хорошим примером является медленное перемещение внутри кафедрального собора или большой пещеры, когда при движении вы слышите долго длящееся эхо. От свойств окружающей среды зависят параметры, определяющие запаздывающий отраженный сигнал.

Переменные механизма расчета звуков, отраженных с запаздыванием (reverb):

· Варьирование уровней входного и выходного звукового сигнала, отраженного с запаздыванием.

· Предварительная задержка искусственного эха (reverb).

· Время затухания запаздывающего отраженного звукового сигнала.

· Ясность (четкая различимость) запаздывающего отраженного звука.

В настоящее время нет возможности использовать поле запаздывающего эха, но такая возможность будет доступна после модернизации драйверов, и, возможно, будет включена в интерфейсе A3D 2.1.

Механизм построения геометрических фигур в пространстве

Геометрический движок или geometry engine в интерфейсе A3D 2.0 это уникальный механизм по своей возможности моделирования отраженных и прошедших сквозь препятствия звуков.

В отличии от менеджера сцены, геометрический движок оперирует с данными на уровне геометрических примитивов: линий, треугольников и четырехугольников. Геометрия может быть определена в двумерном или трехмерном пространстве, соответственно, в случае 3D геометрии, вычисления могут быть очень интенсивными.

Геометрический движок может быть задействован приложением с помощью менеджера сцены или напрямую, для полного контроля над описанием путей распространения волн. В последнем случае, приложение содержит базу данных звуковой геометрии и передает только необходимые в данный момент звуковые полигоны в геометрический движок.

Геометрический движок использует полученные звуковые полигоны для построения системы координат, определяющей взаимное расположение слушателя и источников звука.

Звуковой полигон (audio polygon) имеет местоположение, размер, форму, а также свойства материала из которого он сделан. Форма полигона и его местоположение в пространстве связаны с источниками звука и слушателем, влияя на определение того, как каждый в отдельности звук отражается или проходит сквозь полигон. Свойства материала, из которого состоит полигон, могут изменяться от полностью прозрачного для звуков до полностью поглощающего или отражающего.

Очень важно иметь минимальную по размерам базу данных акустических полигонов, что бы минимизировать загрузку CPU. В играх должно быть задействовано около 50 звуковых полигонов в любой момент времени. Этого количества достаточно для описания сложной акустики и представления всех важнейших случаев прохождения звуков сквозь препятствия. Более того, звуковые полигоны должны быть так же точно определены, как и их эквиваленты в графике.

Материалы

Каждый раз, когда звук отражается от объекта, материал из которого сделан объект влияет на то, как сильно поглощается каждый частотный компонет звуковой волны и как много компонетов отражается обратно в окружающую среду. Материалы, используемые для звуковых полигонов могут быть определены в интерфейсе A3D 2.0.

Переменные материалов:

· Заранее определенные материалы: дерево, бетон, сталь, ковер.

· Отражающие свойства: меняются от полностью отражающих до совсем неотражающих звуки.

· Свойства звуковых преград: меняются от полностью прозрачных до непрозрачных для звуков.

После ввода всех необходимых данных, геометрический движок вычисляет ранние отраженные звуки и звуки прошедшие сквозь препятствия, основываясь на свойствах материалов. Уровень детализации звучания и режим реализации акустической модели могут быть установлены с помощью геометрического движка.

Звук прошедший через преграду (occlusions): геометрические алгоритмы вычисляющие то, как звук преодолевает преграду в виде поверхностей. Точность и качество реализации могут быть принесены в жертву скорости вычислений.

Один раз отраженные звуки: вновь, качество реализации может быть принесено в жертву скорости вычислений.

Менеджер сцены

Менеджер сцены использует высокоуровневую базу данных звуковой геометрии и управляет звуковыми полигонами, используемыми в сцене. Приложения создают высокоуровневые объекты, называемые стенами (walls), проходами (openings) и помещениями (rooms), которые могут быть использованы в акустической сцене. Обычно, программа загружает сцену и просто вызывает функцию реализации. Менеджер сцены использует акустическую сцену для определения соседства помещения (т.е. что смежно с помещением) и уровень слышимости. Слышны только те звуки, которые распространяются в помещении, где в данный момент находится слушатель, и звуки в смежных помещениях. Менеджер сцены определяет необходимые для данной сцены полигоны и пересылает их геометрическому движку для построения акустической модели.

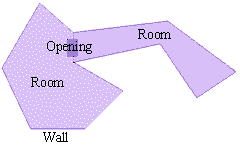

Примеры высокоуровневых объектов:

· Стены: имеют свойства материала из которого они сделаны. Они могут двигаться и менять ориентацию в пространстве. Не все сцены должны отражать звук.

· Проходы: это отверстия в стенах; звук перемещается от одной стороны стены к другой стороне. Проходы могут быть открытыми и закрытыми.

· Помещение: это пространство, которое со всех сторон полностью окружено стенами.

· Сцена: это набор из помещений.

Менеджер сцены от Aureal описывет пути распространения звуковых волн для каждого уровня в форме упрощенных полигонов.

Использование технологии Wavetracing в играх

Реализация wavetracing весьма сложна. Существуют простые высокоуровневые способы доступа (через менеджер сцены и загрузчик сцены) для людей, которым нужен быстрый результат. Дополнительно, доступно управление на низком уровне для разработчиков, которые хотят "сделать акустику действительно ошеломляющей, т.е. совершенно на новом уровне".

Быстрый и простой способ расчета путей распространения звуковых волн

Быстрый и грубый способо добиться этого, это использовать менеджер сцены. По мнению Скипа Макилвейна (Skip McIlvaine) из Aureal, база данных графической геометрии может быть пропущена через конвертер, который преобразует все необходимые графические полигоны в звуковые полигоны за время загрузки уровня игры. Глобальные значения могут быть установлены для параметров объектов отражающих и препятствующих звуку. Кроме того, возможно произвести обработку базы данных графической геометрии заранее, прогнав алгоритм преобразования полигонов и храня базу данных звуковой геометрии в качестве отдельного файла-карты и подгружать этот файл во время загрузки уровня игры.

Тонкая регулировка wavetracing

Существует несколько способов, с помощью которых разработчик звукового оформления может тонко регулировать пути распространения звуковых волн для достижения лушей производительности и эффекта реалистичности: