Навигация

Информация о массе тела может представляться, вообще говоря, многими способами

1. Информация о массе тела может представляться, вообще говоря, многими способами.

2. В качестве носителей непрерывной информации могут использоваться любые физические величины, принимающие непрерывный “набор” значений (правильнее было бы сказать принимающие любое значение внутри некоторого интервала).

Отметим, что физические процессы (перемещение, электрический ток и др.) могут существовать сами по себе или использоваться, например, для передачи энергии. Но в ряде случаев эти же процессы применяются в качестве носителей информации. Чтобы отличить одни процессы от других, введено понятие “сигнал”.

Если физический процесс, т.е. какая-то присущая ему физическая величина, несет в себе информацию, то говорят, что такой процесс является сигналом. Именно в этом смысле пользуются понятиями “электрический сигнал”, “световой сигнал” и т.д. Таким образом, электрический сигнал - не просто электрический ток, а ток, величина которого несет в себе какую-то информацию.

Как представлять дискретную информацию?

Как уже говорилось, дискретность - это случай, когда объект или явление имеет конечное (счетное) число разнообразий. Чтобы выделить конкретное из всего возможного, нужно каждому конкретному дать оригинальное имя (иначе, перечислить). Эти имена и будут нести в себе информацию об объектах, явлениях и т. п.

В качестве имен часто используют целые числа 0, 1, 2,... Так именуются (нумеруются) страницы книги, дома вдоль улицы, риски на шкалах измерительных приборов. С помощью чисел можно перенумеровать все “разнообразия” реального мира. Именно такая цифровая форма представления информации используется в ЭВМ.

В обыденной жизни, тем не менее, цифровая форма представления информации не всегда удобна. Первенство принадлежит слову ! Традиционно информация об объектах и явлениях окружающего мира представляется в форме слов и их последовательностей.

Основной элемент в этой форме - слово. Слово - имя объекта, действия, свойства и т.п., с помощью которого выделяется именуемое понятие в устной речи или в письменной форме.

Слова строятся из букв определенного алфавита (например, А, Б, ... , Я). Кроме букв используются специальные символы - знаки препинания, математические символы +, -, знак интеграла, знак суммы и т.п. Все разнообразие используемых символов образует алфавит, на основе которого строятся самые разные объекты:

из цифр - числа;

из букв - собственно слова,

из цифр, букв и математических символов - формулы и т.д.

И все эти объекты несут в себе информацию :

числа - информацию о значениях;

слова - информацию об именах и свойствах объектов;

формулы - информацию о зависимостях между величинами и т.д.

Эта информация (и это очевидно) имеет дискретную природу и представляется в виде последовательности символов. О такой информации говорят как об особом виде дискретной информации и называют этот вид символьной информацией.

Наличие разных систем письменности, в том числе таких, как иероглифическое письмо, доказывает, что одна и та же информация может быть представлена на основе самых разных наборов символов и самых разных правил использования символов при построении слов, фраз, текстов.

Из этого утверждения можно сделать следующий вывод:

Разные алфавиты обладают одинаковой “изобразительной возможностью”, т.е. с помощью одного алфавита можно представить всю информацию, которую удалось представить на основе другого алфавита. Можно, например, ограничиться алфавитом из десяти цифр - 0, 1, ..., 9 и с использованием только этих символов записать текст любой книги или партитуру музыкального произведения. При этом сужение алфавита до десяти символов не привело бы к каким-либо потерям информации. Более того, можно использовать алфавит только из двух символов, например, символов 0 и 1. И его “изобразительная возможность” будет такой же.

Итак, символьная информация может представляться с использованием самых различных алфавитов (наборов символов) без искажения содержания и смысла информации: при необходимости можно изменять форму представления информации - вместо общепринятого алфавита использовать какой-либо другой, искусственный алфавит, например, двухбуквенный.

Форма представления информации, отличная от естественной, общепринятой, называется кодом. Коды широко используются в нашей жизни: почтовые индексы, телеграфный код Морзе и др. Широко применяются коды и в ЭВМ и в аппаратуре передачи данных. Так, например, широко известно понятие “программирование в кодах”.

Кроме рассмотренных существуют и другие формы представления дискретной информации. Например, чертежи и схемы содержат в себе графическую информацию.

Как измерить информацию?

Как уже говорилось в примере с номером квартиры, одни сведения могут содержать в себе мало информации, а другие - много. Разработаны различные способы оценки количества информации. В технике чаще всего используется способ оценки, предложенный в 1948 году основоположником теории информации Клодом Шенноном. Как было отмечено, информация уничтожает неопределенность. Степень неопределенности принято характеризовать с помощью понятия “вероятность”.

Вероятность - величина, которая может принимать значения в диапазоне от 0 до 1. Она может рассматриваться как мера возможности наступления какого-либо события, которое может иметь место в одних случаях и не иметь места в других.

Если событие никогда не может произойти, его вероятность считается равной 0. Так, вероятность события “Завтра будет 5 августа 1832 года” равна нулю в любой день, кроме 4 августа 1832 года. Если событие происходит всегда, его вероятность равна 1.

Чем больше вероятность события, тем выше уверенность в том, что оно произойдет, и тем меньше информации содержит сообщение об этом событии. Когда же вероятность события мала, сообщение о том, что оно случилось, очень информативно.

Количество информации I, характеризующей состояние, в котором пребывает объект, можно определить, используя формулу Шеннона:

I = -(p[1]*log(p[1])+p[2]*log(p[2])+...+p[n]*log(p[n])) ,

здесь

n - число возможных состояний;

p[1],...p[n] - вероятности отдельных состояний;

log( ) - функция логарифма при основании 2.

Знак минус перед суммой позволяет получить положительное значение для I, поскольку значение log(p[i]) всегда не положительно.

Единица информации называется битом. Термин “бит” предложен как аббревиатура от английского словосочетания “Binary digiT”, которое переводится как “двоичная цифра”.

Похожие работы

... совокупности изображаются не геометрическими фигурами, а символами или знаками, воспроизводящими в какой-то степени внешний образ статистических данных. Достоинство такого способа графического изображения заключается в высокой степени наглядности, в получении подобного отображения, отражающего содержание сравниваемых совокупностей. Важнейший признак любой диаграммы - масштаб. Поэтому чтобы ...

... . Это влияло на входную информацию, например, такие ЭВМ не были способны на работу в многозадачном режиме, в режиме реального времени (обработки сообщений по мере получения входных данных). Информация по отношению к конечному результату проблемы бывает: исходная (на начало актуализации этой информации); промежуточная (от начала до завершения актуализации информации); результирующая (после ...

... навыков, умений. Да и наша педагогическая теория недостаточно помогает в этом. В специальных исследованиях, в отдельных педагогических изданиях самостоятельная работа чаще всего рассматривается или в общем виде, или же даются отдельные указания для её использования. Освещаются и классифицируются виды и формы этой работы, раскрываются условия их применения, направленные на вооружение обучаемых ...

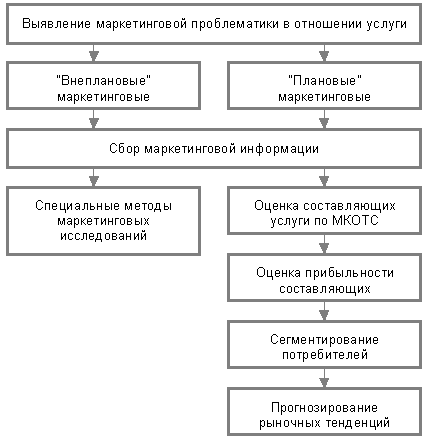

... . Соотношение по объему выполнения работ внутренними и внешними службами определяется из соотношения экономической рациональности для предприятия. Маркетинговые исследования услуги разделяются по характеру выполнения исследования на "плановые" и "внеплановые" мероприятия. Плановые мероприятия - это комплекс маркетинговых исследований, ориентированных на получение стандартизированного объема (по ...

0 комментариев