Навигация

Оптимизация сайта для поисковых машин

4. Оптимизация сайта для поисковых машин

Поисковые машины сегодня являются важнейшим инструментом навигации в Интернете. С их помощью в Сети ищут информацию, сравнивают, анализируют, спрашивают совета, ищут единомышленников, знакомых и даже смысл жизни. Если ранее более популярным инструментом навигации в Интернете были каталоги, то сегодня их объемы и разветвленность, растущие вслед за нарастанием объемов информации, настолько разрослись, что они либо стали чрезмерно сложными для пользователя, либо содержат очень мало информации. При этом за последние несколько лет существенно улучшилось качество поисковых машин. Поэтому неудивительно, что пользователи массово переключились именно на поисковые машины.

Став наиболее популярными сайтами в Интернете, поисковые системы получили дополнительный эффект размера. Теперь это не только самые посещаемые сайты, но и самые известные. В итоге, когда пользователь в первый раз выходит в Интернет, сначала он идет на тот сайт, который ему уже известен от друзей, из прессы или из рекламы в офлайне, то есть на поисковую машину.

Такое положение вещей сохранится еще в течение долгого времени, так как существенная доля пользователей не очень хорошо знакома с компьютером вообще, и число таких пользователей в нашей стране, видимо, растет. Не слишком подкованные интернетчики используют поисковую строчку машины в качестве навигационной строки браузера. Многие пользователи вообще не различают понятия «Интернет» и «поисковая машина». Это хорошо видно по количеству поисковых запросов, содержащих адрес сайта.

Поэтому для многих компаний так важна такая оптимизация сайта, как процесс достижения первых мест в результатах поиска в поисковых машинах по целевым дня компании запросам. Почему важно занять одно из первых мест? Потому что пользователи в среднем просматривают одну страницу результатов поиска и редко переходят на сайты, ссылки на которых есть только на второй странице и дальше.

Да что там вторая страница! Исследование переходов пользователей из результатов поиска системы Яндекс, проведенное несколько лет назад компаниями SpyLOG и «Ашманов и партнеры», показало, что доля переходов, которую можно ожидать на седьмой строке, стремится к нулю, то есть сайты, оказавшиеся ниже шестого места в результатах поиска, — тоже «за бортом». Над результатами поиска стоят рекламные строчки, которых становится все больше со временем. Они тоже уменьшают количество переходов, которое достается сайтам в результатах поиска, потому что для пользователей это тоже результаты поиска.

К слову сказать, для североамериканских сайтов доля переходов с поисковых машин от всех переходов в среднем составляет 60%, а для корпоративных сайтов — и того выше. То есть более половины всех посетителей получают средний сайт с поисковой машины. В русскоязычном Интернете доля поискового трафика ниже, однако все равно очень велика и постоянно растет.

Именно поэтому оптимизация сегодня — большой, разветвленный рынок услуг, игроков на котором существенно больше, чем на рынке интернет-рекламы. А объем этого рынка услуг в России за 2008 г. оценивается в 200 млн долл., что всего лишь втрое меньше рынка рекламы. А как же иначе, если эффективность этого маркетингового метода никак не ниже других инструментов рекламы в Интернете!

Оптимизация — это набор технических приемов и методов, которые позволяют достичь верхних строчек в результатах поиска. Все приемы оптимизации открыты и описаны на многочисленных форумах, специализированных сайтах оптимизаторов и в бесчисленных статьях. Очень важно, что никаких «тайных» способов оптимизации нет. Здесь все прозрачно и давно известно. Наибольшее значение в скорости получения результатов оптимизации имеет опыт оптимизатора, то есть умение быстро оценить ситуацию и выбрать правильные методы работы, однако даже новичок, вооруженный терпением и усидчивостью, может достичь превосходных результатов.

Начиная процесс оптимизации, следует четко осознавать следующие моменты.

Это путь проб и ошибок. Несмотря на то, что есть довольно точные «рецепты успеха», в каждом конкретном случае они могут «не сработать», причем вероятность их срабатывания тем ниже, чем больше коллег-оптимизаторов трудятся над теми же поисковыми словами и в том же секторе рынка. Необходимо пробовать все способы оптимизации для достижения результата.

Оптимизация — это долгий процесс. Даже если быстро внести изменения в сайт, поисковый робот обновит информацию о сайте в базе не сразу, а в лучшем случае через несколько дней, скорее даже через неделю. Именно поэтому процесс оптимизации обычно затягивается на многие месяцы и все результаты приходят очень постепенно.

Оптимизация — очень кропотливый процесс, где надо учитывать множество факторов: особенности каждой поисковой машины, особенности рынка, на котором работает компания, активность конкурентов и действия, которые они предпринимают, и проч. Более того, все эти факторы необходимо учитывать постоянно, а не один раз при запуске.

Оптимизация — это нестабильный процесс. Алгоритмы поисковых машин постоянно меняются, кроме этого, меняется и ландшафт рынка за счет конкурентов и тех действий по оптимизации, которые они предпринимают. Поэтому те успехи, которых компания добилась несколько дней (недель) назад, сегодня могут превратиться в ничто. Следовательно, оптимизацией необходимо заниматься постоянно.

Поисковые машины сопротивляются усилиям оптимизаторов, поскольку они ухудшают качество поиска. Жестко и в одностороннем порядке поисковые машины регламентируют допустимое поведение оптимизаторов и бесцеремонно удаляют из результатов поиска (поисковой выдачи) сайты, которые, по их мнению, эти правила не соблюдают. Более того, эти правила не публикуются и постоянно меняются, так что любое действие по оптимизации завтра может оказаться «вне закона».

Факторы, влияющие на ранжирование результатов поиска в поисковых машинах

Поисковая машина выстраивает сайты в результатах поиска в соответствии с их релевантностью введенному запросу, то есть по соответствию сайта некоему «эталону», который она должна показать пользователю в ответ на его запрос. Анализ соответствия проводится по множеству параметров, каждый из которых влияет на общий результат и имеет свой собственный вес. Набор этих параметров и их весов называется «формулой релевантности» и является одной из самых охраняемых тайн поисковых машин. Более того, формула релевантности постоянно меняется, для того чтобы улучшить результаты поиска, нейтрализовать усилия оптимизаторов, попробовать новые сочетания. Каждая поисковая машина имеет свою собственную формулу релевантности, и поэтому оптимизировать сайт приходиться под каждую поисковую машину отдельно.

Несмотря на то, что формула релевантности — это тщательно охраняемый секрет поисковых машин, все компоненты этой формулы хорошо известны, собственно поисковые машины скрывают лишь веса каждой составляющей формулы. Поэтому оптимизаторы постоянно экспериментируют в попытках отыскать тот самый «рецепт живой воды», немного изменяя различные факторы и отслеживая результат.

Всего на оптимизацию влияют три группы факторов:

1. Содержание. Для того чтобы поисковая машина нашла по заданному ключевому слову страницу сайта, в тексте страницы сайта обязательно должны содержаться эти ключевые слова. Понятно, что если на сайте нет словосочетания «интернет-маркетинг», или «колючий ежик», или «автомобильный холодильник», то поисковая машина вряд ли поместит такой сайт в результаты поиска по указанным словам. Следовательно, на сайте обязательно должны встречаться ключевые слова.

Только упоминания ключевых слов на сайте недостаточно. Необходимо, чтобы ключевые слова встречались на сайте часто, причем в разных вариантах, в разных словосочетаниях, разных формах. Это называется частотность и вариативность Логика поисковой системы создана людьми, и она похожа на человеческую. Поэтому если в тексте часто встречается слово, например, «ежик колючий», причем в разных падежах и словосочетаниях, то поисковой машине «становится понятно», что этот текст о ежиках, причем в первую очередь о колючих ежиках.

В то же время ключевые слова не должны встречаться слишком часто, так как в этом случае поисковая машина блокирует страницу или сайт целиком. Дело в том, что «набивка», то есть наполнение страницы сайта бесчисленным количеством одинаковых словосочетаний — один из самых старых методов оптимизации, считающийся поисковыми машинами «нечестным» (вспомним про одностороннюю установку правил). В общем, это верная логика, существует лишь небольшое число текстов, в которых использование ключевых слов чаще, чем 5% от общего количества всех слов в тексте, является нормальным, например упражнения по русскому языку.

Конечно же, при анализе текстов поисковыми машинами учитывается длина текста. Если содержание страницы — это фотография или схема, над которой написано название из трех слов, то эта страница не будет заблокирована. Нужно понимать, что поисковые машины развиваются давно, они прошли в своем развитии несколько стадий, в том числе и стадию борьбы с поисковым спамом. Поэтому механизмы борьбы с ним хорошо отстроены.

Ключевые слова, встречающиеся близко к началу страницы (к началу текста на странице), имеют больший вес, чем те, что в конце. Поэтому еще один важный фактор это группы — близость к началу страницы.

Но одной частоты упоминаний недостаточно, важно, чтобы ключевое слово встречалось на странице чаще других слов. Это называется концентрация, которая приводит нас к простому правилу — одна страница может быть оптимизирована под одно ключевое слово или под одну цепочку ключевых слов (то есть по словам «ежик», «ежик колючий», «ежик колючий сезонный», «ежик неколючий», «линька ежиков»...). В свою очередь, это правило имеет одно простое и очень четкое следствие — чем больше контента, тем больше переходов из поисковиков.

2. Оформление. Еще раз вспомним о том, что поисковые машины создавали люди и вложили в них свою логику. Поэтому понятно, что если ключевое слово каким-то образом выделено на странице, то этому слову на странице уделяется особенное внимание, а страница посвящена предмету или понятию, которое обозначает выделенное слово. Следовательно, после того как мы составили страницу, на которой ключевое выражение встречается достаточное количество раз и в разных вариантах, необходимо его выделить. Для этого существует немало способов.

Название страницы. Пишется на строке заголовка браузера. Это название указывается между тегами title в коде страницы. В общем случае в названии страницы должна быть конструкция следующего вида: «название страницы, название раздела, название сайта». Заголовок первого уровня имеет, конечно, наибольший вес, однако при подсчете релевантности учитываются все заголовки. Все заголовки страниц на сайте должны быть разными.

Заголовок текста. Важно помнить, что поисковые машины не умеют «читать» в нашем понимании, поэтому они разбирают только стандартные заголовки. В HTML это теги HI, H2, НЗ ... Н7, поэтому необходимо определять заголовки именно этими тегами, после чего задавать им нужный вид в каскадной таблице стилей — CSS.

Курсив, полужирное начертание. Курсивом или полужирным начертанием выделяются обычно названия статей в энциклопедиях или словарях, и поисковые машины традиционно уделяют им большое внимание. Необходимо, как и везде, следить, чтобы все выделения делались способами, описанными в стандартах HTML. Если вы хотите, чтобы на самом деле текст выглядел иначе, используйте CSS.

Названия картинок. Тоже должны включать в себя ключевые слова. Поисковые машины обязательно учитывают подписи к рисункам. Кроме того, почти все поисковые машины имеют сегодня поиск по картинкам. Он не пользуется большой популярностью, но даже и те 10% поискового трафика, которые он собирает, — это большая величина, за которую стоит побороться, тем более что конкуренция там меньше. Попасть в поиск по картинкам можно только при помощи подписей к картинкам, сделанных в теге Alt.

Адрес страницы. Этот фактор используется не часто, однако некоторые поисковые машины также принимают его во внимание, особенно для англоязычных запросов. Поэтому полезно иметь в названии сайта и в названии разделов наиболее важные ключевые слова.

Мета-теги. Это специальные контейнеры в заголовке страницы, изначально созданные для поисковых машин, сегодня используются мало, поскольку в мета-контейнеры стали писать все что угодно, но только не правильные ключевые слова для данной страницы. Информация, записанная в два контейнера: metanarne:="keywords''content="">,<metaname="description', content="">, — по-прежнему иногда учитывается поисковыми машинами, правда, с очень низким весом.

![]()

![]()

![]()

![]() 3. ОКРУЖЕНИЕ. В 2002 г. активность оптимизаторов приняла формы, опасные для поисковых машин. Оптимизация сайтов проводилась автоматически при помощи скриптов, страницы оптимизировались сотнями тысяч и даже миллионами по любым словам, не обязательно ключевым для рекламируемого сайта. В итоге базы данных поисковых машин стали представлять собой чудовищную помойку, а качество поиска все ухудшалось и ухудшалось. Поисковые машины и вообще модель навигации через поиск в Интернете были на грани краха...

3. ОКРУЖЕНИЕ. В 2002 г. активность оптимизаторов приняла формы, опасные для поисковых машин. Оптимизация сайтов проводилась автоматически при помощи скриптов, страницы оптимизировались сотнями тысяч и даже миллионами по любым словам, не обязательно ключевым для рекламируемого сайта. В итоге базы данных поисковых машин стали представлять собой чудовищную помойку, а качество поиска все ухудшалось и ухудшалось. Поисковые машины и вообще модель навигации через поиск в Интернете были на грани краха...

На самом деле я немного преувеличиваю, и реальное положение вещей было не столь удручающим, но вот качество поиска в начале 2000-х гг. действительно было очень низким — поисковые машины не справлялись с огромным объемом спама, которым их захламляли оптимизаторы.

Именно в этот момент родилась идея о необходимости использовать в технологии ранжирования какие-то дополнительные параметры, не зависящие или мало зависящие от владельца сайта и вообще внешние по отношению к сайту. Экспериментов в этот момент проводилось довольно много, но самый известный и наилучшим образом зарекомендовавший себя метод — Page Rank, придуманный одним из создателей Google Лари Пэйджем. Суть его в том, что поисковая машина учитывает количество ссылок на сайт и при прочих равных отдает предпочтение тому сайту и той странице, на которую другие сайты ссылаются больше.

С момента изобретения алгоритм претерпел значительные изменения, разветвился и сейчас используется множеством других поисковых машин, а не только Google, в то время как другие механизмы практически не прижились. Например, Rambler в качестве инструмента ранжирования использовал данные собственного счетчика, считая, что из двух сайтов более посещаемый является более релевантным. Еще одним довольно новым, но еще мало распространенным вариантом является механизм меток — один из вариантов социального поиска, когда пользователи поисковой машины размечают результаты поиска вручную. Эти, а также другие пока неудачные эксперименты когда-нибудь снова могут оказаться «в строю» в новом исполнении, но пока Page Rank — основной инструмент оценки окружения сайта поисковой машиной.

На сегодняшний момент механизм Page Rank ранжирует сайты по количеству ссылок на них с других сайтов с учетом количества ссылок на сайты, с которых ведут ссылки. Для этого каждому известному поисковой машине сайту присвоен ранг, который зависит от числа и ранга ссылающихся на него сайтов. Говоря иными словами, одна ссылка с Yahoo стоит существенно больше, чем несколько тысяч ссылок с сайтов-однодневок.

Поисковая система Яндекс использует очень похожий механизм учета ссылок в русскоязычном Интернете, который называется «индекс цитирования». У этого механизма есть свои особенности, однако общая схема выглядит примерно так же. Практически все современные поисковые системы так или иначе используют механизм ранжирования по внешним ссылкам.

Еще одним очень важным инструментом этой же группы факторов являются ссылки на сайт с ключевых слов. То есть ключевое слово является ссылкой на оптимизируемый сайт, например, на каком-либо сайте ставится фраза «все о колючих ежиках», где слова «колючий ежик» являются ссылкой на сайт о них. Влияние этого фактора очень велико для всех поисковых машин, например, при поиске по словосочетанию «вор должен сидеть в тюрьме» в месяц «оранжевой революции» на Украине на первом месте появлялся избирательный сайт Януковича, на котором, конечно, нет таких слов. Добились этого многочисленные поклонники Ющенко — они поставили ссылки с соответствующих слов на сайт Януковича. Другой пример — это третье (а иногда и первое) место сайта Microsoft в результатах поиска по слову «геморрой за свои деньги». Приведенные примеры довольно быстро исчезают: некоторые -— за счет действия оптимизаторов, другие снимаются администрацией поисковой машины, поэтому когда вы будете читать этот текст, то, увы, они уже не будут работать.

Приведенные примеры стали возможны именно благодаря расстановке ссылок на большом количестве сайтов, где ссылка идет с ключевых слов запроса. При этом слова даже не обязательно должны присутствовать на оптимизируемом сайте, хотя, безусловно, в условиях сильной конкуренции одного ссылочного ранжирования будет недостаточно.

Еще один «внешний» фактор — присутствие ссылки на сайт в принадлежащем поисковой системе каталоге или рейтинге. Это дает иногда некоторое преимущество перед остальными в результатах поиска. Одно время у Яндекса сайты, зарегистрированные в каталоге, ставились первыми ссылками в результатах поиска, такая же ситуация была у Rambler. Если регистрация в каком-то определенном месте или использование определенного набора услуг увеличивает шансы подняться наверх результатов поиска, то обычно это указывается на сайте поисковой машины в инструкциях для веб-мастеров. На сегодняшний момент поисковые машины совсем или почти не учитывают наличие сайта в собственных каталогах.

Для оптимизации следует использовать все допустимые возможности, однако необходимо понимать, что факторы первой и третьей групп на сегодняшний день оказывают наибольшее влияние на результат работы специалиста. Иными словами, современная оптимизация — это наращивание объема контента и непрерывная покупка ссылок. Но помните: в силу односторонней игры с правилами никак нельзя гарантировать, что положение вещей сохранится сколько-нибудь длительное время, поэтому вы должны уметь применять все методы.

Составление семантического ядра

Основой для оптимизации сайта является набор поисковых слов, полностью охватывающих тематическое поле компании (или сайта, так как компания может работать в нескольких областях). Этот набор поисковых запросов называется семантическим ядром. Любая оптимизация начинается с составления семантического ядра задолго до начала эксплуатации сайта (одновременно с началом работ по проектированию сайта).

Составление семантического ядра всегда начинается с мозгового штурма: несколько сотрудников компании в процессе обсуждения выявляют два-три десятка основных поисковых запросов, наиболее часто встречающихся в их тематике. Очень полезным оказывается в такой ситуации присутствие сотрудника, непосредственно работающего с клиентами, так как важно использовать именно те слова, которые задают клиенты, а не те, которыми пользуются сотрудники компании.

Например, для тематики «домашняя акустика» рабочая группа, скорее всего, назовет следующие поисковые запросы: колонки, домашний кинотеатр, акустика, музыкальный центр, домашний звук, dolby, усилитель, surround, трехмерный звук, окружающий звук, объемный звук, звук, CD, живой звук.

Полученные два десятка слов проверяются через два специальных инструмента: подбор слов в ЯндексДиректе и связанные поисковые слова на Rambler. Сначала используем связанные словосочетания на Rambler, чтобы открыть колонку связанных запросов, нажимаем ссылку «еще» в результатах поиска внизу.

Связанные поисковые запросы — это поисковые запросы, заданные пользователями в рамках той же сессии работы с поисковой машиной. Иными словами, если пользователь ввел поисковый запрос, результаты поиска по которому его не устроили, то он вводит другой поисковый запрос, чтобы уточнить результаты поиска и получить более подходящие результаты. Такая пара запросов называется связанной. Поисковые запросы отсортированы в таблице по частоте совместного использования (то есть как часто они встречаются в той же сессии, что и основной запрос).

Например, пользователь ввел слово «звук», получил кучу мусора, после чего ввел запрос «объемный звук», результаты ему снова не понравились, тогда он ввел запрос «объемный звук для домашнего кинотеатра, сравнение».

Включенные поисковые запросы — это словосочетания, которые полностью включают в себя какое-либо (или какие-либо) слово из «основного» списка, полученного нами путем предь1дущих действий. Например, словосочетание «ежик в тумане» полностью включает в себя слово «ежик». В процессе оптимизации ключевыми словами являются и те, и другие. Страница, оптимизированная под слово «холодильник», не обязательно будет на первом месте по словосочетанию «белый холодильник Liebherr в Москве». При этом понятно, что слово «холодильник» спрашивают в поисковых машинах чаще, чем упомянутое словосочетание, но и оптимизировать по нему сложнее. К тому же процент клиентов среди тех, кто спрашивает «белый холодильник Liebherr в Москве», существенно выше, чем среди тех, кто спрашивает просто слово «холодильник».

Весь перечень слов и словосочетаний, который мы получили, необходимо также добавить в общий файл, где уже хранятся полученные ранее ключевые слова. Из общего файла следует удалить дубли и выделить в нем все «вредные словосочетания» отдельно, чтобы вставить их в стоп-слова.

В результате проведенной работы должен получиться список из сотен, тысяч, а иногда и десятков тысяч поисковых запросов. Однако это еще не вся работа. В полученный список следует добавить также:

полный список всех торговых марок, названий и брендов для отрасли, по которой собирается семантическое ядро;

список названий, торговых марок и имен конкурентов;

список ключевых фигур (если таковые есть);

полную номенклатуру всех товаров, включая товары конкурентов, даже если они не представлены в компании, но имеют аналоги среди предлагаемой компанией продукции;

распространенные ошибочные написания наиболее часто встречающихся ключевых слов, особенно ошибочные написания основных брендов;

латинизированные написания русскоязычных названий и кириллические написания англоязычных названий для основных брендов;

варианты написания основных ключевых слов и названий с непереключенной раскладкой.

Пункты 5—7 нужно делать только для самых известных названий — тех, которые «на слуху» у пользователей. Например, название Samsung люди знают и будут спрашивать как самсунг, sumsung, а вот название K-systems почти никто не знает, и его правильное написание будут спрашивать очень немногие, а ошибки вряд ли встретятся сколько-нибудь заметное количество раз. Нет смысла тратить ресурсы на бренд, который почти никому не известен.

В итоге вы получаете полный список ключевых слов и выражений, описывающих тематическую область, и всех тех слов и выражений, которые могут задать пользователи для поиска товаров и услуг в выбранной тематике. Многие, даже большинство из этих слов, будут заданы пользователями всего один раз в месяц, а то и реже, однако пользователь, который однажды введет поисковый запрос «ABCXXRT1284R, цена», попадет на сайт компании, потому что компания заранее позаботилась об этом. В сумме количество переходов (а главное — клиентов), полученных с редко задаваемых слов, может оказаться больше, чем с наиболее частых слов в тематике, которые задают десятки и сотни тысяч раз в месяц. Это называется «стратегия длинного хвоста».

Полученный список поисковых запросов — семантическое ядро — вы будете использовать не только для оптимизации, но также и для размещения контекстной рекламы. Семантическое ядро — один из важных элементов интернет-маркетинга. Его необходимо регулярно обновлять и корректировать при появлении новых продуктов и марок.

Последовательность оптимизации

В семантическом ядре присутствуют слова и выражения совершенно разного уровня. Здесь есть поисковые запросы, которые спрашивают всего несколько раз в месяц, а есть такие, которые запрашивают в месяц десятки тысяч раз. Понятное дело, что оказаться на первых местах в результатах поиска по наиболее частотным поисковым запросам — очень привлекательная задача.

Именно поэтому ее пытаются решить многие оптимизаторы, и именно за наиболее частотные запросы идет основная «битва титанов оптимизации». Соответственно, для оптимизации по наиболее частотным запросам необходимо использовать весь «арсенал» методов, тогда как для того, чтобы иметь «длинный хвост», зачастую достаточно лишь грамотно написать тексты и правильно расставить ссылки внутри сайта.

Под наиболее частотные запросы обычно оптимизируется титульная страница сайта, на которую ведет больше всего ссылок, а следовательно, именно она будет иметь наибольший вес среди всех страниц сайта. По менее частотным запросам оптимизируются главные страницы разделов, а по «длинному хвосту» оптимизируются рядовые страницы сайта.

Таким способом, при оптимизации мы получаем стройную работающую независимо в своих компонентах систему. Наращивание контента медленно увеличивает количество переходов с поисковых систем, оптимизация первой страницы и страниц разделов увеличивает посещаемость скачками. В то же время сбой в оптимизации главной страницы и страниц разделов точно так же скачками уменьшает число переходов на сайт с поисковых систем.

Важно, что процесс оптимизации начинается до работ над сайтом и, конечно, до его запуска. Уже при выборе системы управления контентом необходимо предусмотреть все необходимые модули, которые позволят оптимизировать сайт: возможность изменения названий страниц, тегов заголовков, мета-тегов, подписей к рисункам, структур, ссылок, видов адресов и пр.

В этот же момент делается анализ конкурентов, исследуются их сайты, то, какие методы они применяют и какие средства необходимы для того, чтобы опередить конкурентов и выйти на первые места. Одновременно с анализом конкурентов собирается семантическое ядро.

Например, нередкой ошибкой для оптимизации является Java или Flash-меню. Поисковый робот не умеет пользоваться этими технологиями, как не умеет вводить в формы на сайте какие-либо слова (если, например, некоторые данные с сайта можно получить, только вбив в форму запроса что-либо). Поэтому внутренние страницы такого сайта никогда не будут проиндексированы. Другой пример — очень большое количество вложений в навигации по сайту (большая глубина каталога). Поисковая машина, конечно, проиндексирует все, но будет делать это крайне медленно, поскольку за каждый проход сканирует сайт лишь на определенную глубину. Еще одна ошибка — это использование непрямых ссылок (ссылки через базу данных или динамическую библиотеку), которые могут меняться со временем. Поисковая машина будет постоянно сбрасывать сайт вниз, так как будет «терять» адреса страниц. Наконец, использование идентификаторов sessid, позволяющих упростить работу сложных сайтов, в некоторых случаях вообще делает индексацию сайта невозможной. Таких ошибок огромное количество, они все описаны, но проектировать сайт с учетом работ по оптимизации проще, чем потом исправлять ошибки.

Уже после создания дизайна сайта и верстки необходимо проанализировать проделанную работу на соответствие требованиям оптимизации и внести нужные исправления. Одновременно проверяется еще раз работоспособность инструментов оптимизации, присутствующих в системе управления контентом сайта.

После открытия сайта и индексирования его в поисковых машинах задача оптимизации заключается в непрерывной проверке результатов предыдущих работ. Вторая часть работы — это покупка (реже — обмен) большого числа ссылок на сайт для увеличения индекса цитирования. Это нужно делать постоянно, более того, постоянно нужно мониторить уже поставленные ссылки. Наконец, третье — это изменения на сайте, чтобы постоянно улучшать результаты.

Для упрощения работ по оптимизации применяется специализированное программное обеспечение, используемое в основном для анализа конкурентов, проверки мест в поисковых машинах по многочисленным поисковым запросам, сбора слов и выражений. Различных программных продуктов довольно много, наиболее известными сегодня в России являются SEMonitor, SEORate, NetPromoter, CS Yazzle, хотя есть еще десятки других программ, скриптов, онлайн-сервисов и проч.

«Серые» методы оптимизации

Некоторые методы оптимизации являются «противоправными» (с точки зрения поисковых машин), однако они позволяют достичь быстрого, подчас немедленного эффекта. Эти методы все вместе называются «спамдексингом». При использовании «серых» методов оптимизации сайт в одночасье может быть «забанен» поисковой системой, и вернуть его после этого обратно в индекс будет достаточно сложным делом. В том случае, если сайт исключен из индекса за нарушения, необходимо списаться со службой поддержки поисковой системы, попросить разъяснений, возможно, внести исправления — в общем, вступить в переговоры.

Чаще всего такие методы оптимизации используют случайные компании оптимизаторов, задача которых — быстро заработать деньги и исчезнуть с рынка. Действительно, результаты работы компании в этом случае видны очень быстро, почти сразу, и не важно, что уже через несколько дней или недель эти результаты превратятся в пыль, а заказчику придется вести длительные переговоры с поисковыми системами, а потом начинать все работы по оптимизации сначала.

Не лучше ситуация, когда сотрудник компании, начитавшись разнообразных форумов, нахватавшись знаний из блогов оптимизаторов, начинает оптимизировать сайт компании, не представляя себе последствий, которые могут иметь его действия. Проблема усугубляется тем, что с модератором поисковой машины для разрешения возникшего противоречия будет общаться впоследствии все тот же человек. Последствия такого разговора непредсказуемы.

Поэтому очень полезно представлять, какие именно методы оптимизации поисковые машины относят к «серым» или «черным», Помните также, что главный инструмент борьбы с накруткой — это конкуренты, которые сами и расскажут модератору поисковой машины о найденных нарушениях.

Итак, к «серым» методам оптимизации относятся:

1) НАБИВКА — наполнение страницы ключевыми словами и выражениями, не несущими смысловой нагрузки в контексте сайта, чаще всего невидимыми для пользователя. Я уже упоминал этот термин выше. Набивка чаще всего вьгглядит как мелкий текст, состоящий из одного и того же слова или небольшого набора слов внизу страницы. Довольно часто при набивке используют такой же цвет текста, как и цвет фона. Поисковые машины автоматически отлавливают такой фокус, однако только в том случае, если он выполнен стандартными HTML-средствами, а не при помощи CSS.

Набивка — один из самых старых способов скоростной оптимизации, сегодня он не приносит впечатляющих результатов, поскольку вес частоты встречаемости в тексте выражения не столь велик, как раньше. Тем не менее этот метод часто используется, поскольку автоматические фильтры поисковых машин не всегда на него срабатывают.

Вариантом набивки является вполне «разрешенный» способ: установка ссылки на основные товарные группы на главной и всех остальных страницах, как, например, это сделано на сайте www.pleer.ru. Такой вариант оптимизации увеличивает релевантность страницы.

2) КЛОАКИНГ — демонстрация поисковому роботу, индексирующему сайт, и обычному пользователю разного контента. Другими словами, пользователь видит один сайт, а индексирующий поисковый робот — другой. Разделение происходит на уровне IP-адреса пользователя или по User Agent: специальный скрипт на сервере определяет пользователя по тем или иным критериям и подготавливает для него определенную страницу. Этот метод, носящий столь неблагозвучное название, часто используется сайтами вовсе не для обмана поисковых машин, а для облегчения жизни пользователей. Например, показ пользователю сайта на том языке, который у него установлен основным в браузере, или многие новостные сайты показывают пользователям различный набор новостей в зависимости от места, где тем не менее поисковые машины считают такое поведение некорректным и иногда банят такие сайты, несмотря на неоднозначность использования. В то же время автоматической системы определения клоакинга пока нет ни у одной поисковой машины, так что все подозрительные случаи идентифицируются модераторами или, опять же, конкурентами. Все такие случаи разбираются вручную, что несколько снижает риск автоматического отключения, хотя и модератор, бывает, ошибается;

3) ДОРВЕИ — создание большого числа отдельных независимых страниц, оптимизированных под низкочастотные запросы, которые перенаправляют посетителей на оптимизируемый сайт. Таким образом, делается оптимизация не самого сайта, а страниц, не имеющих к сайту никакого отношения, и расположенных на стороннем хостинге под другими доменными именами. Такой вид оптимизации очень хорошо заметен тем, кто активно пользуется поисковыми машинами, хотя его формы могут быть очень причудливы. Это автоматически пробрасывающие на совершенно другой сайт пустые страницы с единственной ссылкой, содержащей введенный пользователями запрос, ведущий неизвестно куда, целые страницы с перечнем ссылок, подчас не имеющих никакого отношения к тому, что вы искали. Дорвеи — это нетематические страницы, предназначенные исключительно для того, чтобы «пробросить» посетителя на нужный адрес.

Последнее время дорвеи чаще используются для прямого перенаправления посетителей на рекламные ссылки. Собирая бесплатные переходы по низкочастотным запросам в поисковых машинах, они отправляют пользователей на страницы, набитые рекламой, например на страницы «Бегуна».

Поисковые машины очень жестко борются с дорвеями, поскольку они действительно сильно ухудшают результаты поиска, замусоривают его своими бесчисленными клонами. Сегодня дорвеи создаются автоматически при помощи скриптов, способных создать тысячи и сотни тысяч страниц за считанные часы, и эта проблема для поисковых машин очень актуальна. Чтобы понять масштабы бедствия, достаточно вспомнить два случая, произошедших в 2006 г. Примерно в середине года выдача Google оказалась буквально завалена несколькими миллионами дорвеев, созданных одним предприимчивым белорусским оптимизатором. Некоторые из созданных им страниц функционируют до сих пор, принося кому-то трафик. А в начале весны 2006 г. в одном из интервью главный редактор Яндекса Елена Колмановская заметила, что количество дорвеев, появившихся в индексе поисковой машины за последние два месяца, превышает их количество за все предыдущие годы работы. Именно в 2006 г. работы дорвей-щиков резко усилились, и эта ситуация удручает и сегодня.

В случаях частотных поисковых запросов (тех, что спрашивают тысячи, десятки и сотни тысяч раз в месяц) дорвеи не видны пользователю, они не поднимаются на первую десятку страниц выдачи (и даже на первую сотню). Причина, конечно, в активности оптимизаторов, которые используют куда более серьезные методы, чем те, что заложены в дорвеи. А вот для низкочастотных запросов, где активность оптимизаторов невелика, а часто вообще отсутствует, дорвеи процветают. Здесь их можно встретить чуть ли в не в каждой выдаче.

К сожалению, пока не существует однозначного и эффективного способа определения дорвеев и удаления их из поискового индекса. Некоторые очевидные варианты определяются и удаляются роботами, еще некоторое количество страниц удаляется благодаря жалобам пользователей, но технологии не стоят на месте не только у поисковых машин, но и у спамеров. Пока дорвеи эту битву выигрывают.

Наиболее масштабные дорвейные сетки, объединяющие несколько миллионов страниц, собирающих трафик в разных поисковых системах, создают специальные сервисы, продающие трафик заинтересованным сайтам. Сегодня это мощные агентства, имеющие достаточно средств на разработки и развитие технологий.

4) НЕПОТИЗМ — взаимный обмен ссылками с целью увеличения индекса цитирования (Page Rank) без содержательного значения ссылок, то есть без тематической необходимости. После начала активного использования механизмов определения релевантности (веса) страниц по объему ее цитирования разного уровня появились целые могильники ссылок на сайтах, где размещались взаимные ссылки на десятки, сотни, а иногда и тысячи сайтов. Это действительно повышало и повышает Page Rank, пускай и не намного. В данном случае незначительность повышения искупается количеством ссылок, то есть количеством этих самых незначительных повышений.

Заключение

В итоге в Интернете появились целые «грозди» перевитых коммерческими ссылками сайтов, а «обмен ссылками» в какой-то период стал очень активным бизнесом. Сейчас активность немного утихла, и ссылки в основном покупают, то есть приобретается постоянное размещение ссылки на популярном сайте, поскольку это проще, надежнее и лучше поддается контролю, чем обмен.

Поисковые машины борются с непотизмом, поскольку не без оснований видят в нем искусственное, необоснованное реальной значимостью повышение «веса» сайта. На сегодняшний день не существует надежной и адекватной системы распознавания взаимного обмена ссылками более чем между тремя сайтами, которые ссылаются «по кругу», поэтому определение таких сайтов делается чаще всего на основе жалоб конкурентов.

Важно, что в качестве одного из методов, которые поисковые машины применяют для борьбы с непотизмом, выступает обратный индекс цитирования, то есть понижение веса сайтов, на которые стоят ссылки с таких «линк-помоек» (конечно, известных поисковой машине). Это недавнее нововведение требует более аккуратного подхода к работе со ссылками.

Спамдексинг сегодня используется очень часто, и до какого-то момента он, конечно, очень эффективен, иначе бы не использовался. Однако, если работа сайта планируется не на месяц, а на годы вперед, то использовать спамдексинг не стоит: в долговременной перспективе он не приносит положительного результата. В первую очередь, я уже отмечал это, вследствие высокой активности конкурентов.

Список использованной литературы

1. Баззел Р., Кокс Д., Браун Р. Информация и риск в маркетинге/Пер. с англ.-М.: Финстатинформ, 2007.

2. Данько Т.П. Управление Интернет-маркетингом: Учебное пособие.- М.: Инфра-М, 2007.

3. Пешкова Е.П. Маркетинговый анализ в деятельности фирмы. - М.: «Ось-89», 2009.

4. Черчиль Г.А. Маркетинговые исследования в Интернете / Пер. с англ.-СПб.: Питер, 2008.

5. Реклама и маркетинг в Интернете: пер. с англ./ Кеглер, Томас, Даулинг, Пауль, Тейлор, Бренд, Тестерман, Джошуа. - М.: Альпина Паблишер,2009.

6. Алексунин, Владимир Алексеевич Электронная коммерция и маркетинг в Интерненте: учеб. пособие/ Алексунин, Владимир Алексеевич, Родигина, Валентина Васильевна. - М.: Дашков и К,2010.

Похожие работы

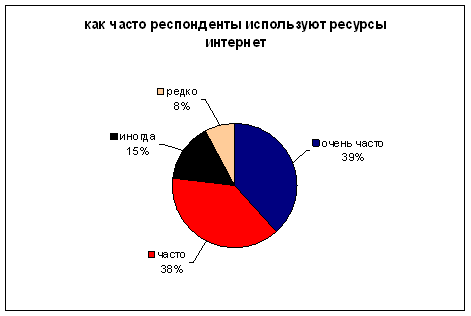

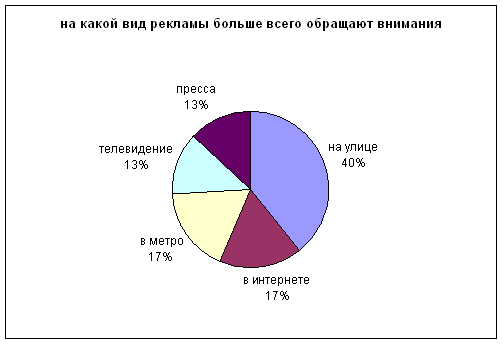

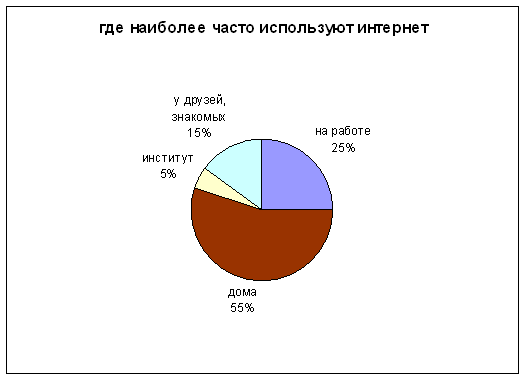

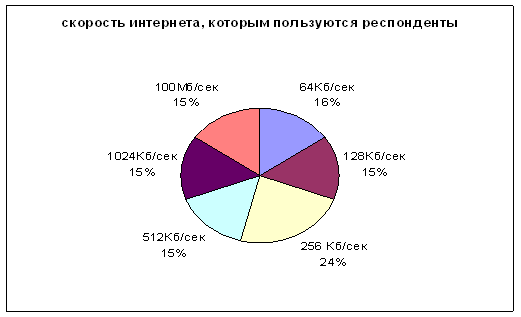

... вам, постоянных покупателей очень важно. Однако отследить повторные действия можно только при условии идентификации пользователя при каждом совершении этого действия. [11] Социологическое исследование Анкеты по теме эффективность баннерной рекламы в интернете отдавались опрашиваемым двумя способами. Первый способ: лично в руки; второй: по электронной почте. Соответственно инструкция по ...

... увеличения продаж. 6. На порядок более высокие цифры по увеличению Brand Awaraness и Consumer Loyalty наблюдаются для новых, нераскрученных брэндов. Методы и механизмы оплаты баннерной рекламы в Интернете. Обычно устанавливается фиксированная цена за тысячу показов рекламного баннера, которая значительно ниже стоимости традиционной рекламы в СМИ. Кроме того, существуют схемы оплаты за ...

... , используется двухуровневый подход, когда на веб-сервере размещается некоторая информация про предприятие, товары и услуги, а все рекламные усилия направляются на привлечение посетителей на сервер. Реклама в Интернет призвана выполнять маркетинговые (формирование и стимулирование спроса на товар), образовательные, коммуникативные, социальные, экономические задачи [5]. 2. ВИДЫ РЕКЛАМЫ И ТИПЫ ...

... считается одним из самых популярных способов наращивания траффика (привлечения посетителей) веб-страницы, средством привлечения новых клиентов, а также мощным инструментом имиджевой рекламы в Интернете. Рекламные баннеры бывают графическими и текстовыми. Графические баннеры обычно представляют собой статическое или анимационное изображение определенного размера (наиболее распространены форматы ...

0 комментариев