Навигация

Мультиколлинеарность переменных

1.4 Мультиколлинеарность переменных

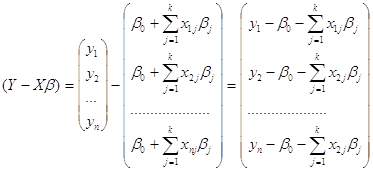

Одно из основных предположений регрессионного анализа относится к матрице исходных данных: среди независимых переменных не должно быть линейно зависимых. Это требование необходимо для вычисления оценки ![]() методом наименьших квадратов.

методом наименьших квадратов.

Мультиколлинеарность приводит к:

1)снижению точности, дисперсия оценок увеличивается, параметры модели коррелированны, что приводит к трудностям в интерпретации модели;

2)оценки коэффициентов становятся чувствительны к особенностям множества выборочных данных.

Причиной мультиколлинеарности могут служить:

1) наличие автокорреляции в ряду наблюдений;

2) корреляция между переменными;

3) высокий уровень помех.

Под мультиколлинеарностью будем понимать сопряженность независимых переменных, это означает "почти линейную зависимость" векторов ![]() , т.е. существование чисел

, т.е. существование чисел ![]() таких, что:

таких, что:

![]() (3.3)

(3.3)

Когда равенство (3.3) имеет место, говорят о строгой мультиколлинеарности.

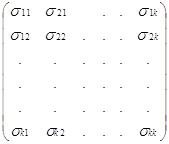

При наличии мультиколлинеарности оценки МНК становятся положительными, т.е. дисперсия оценок будет весьма большой. При наличии (3.3) матрица ![]() становится плохо обусловленной, в частности

становится плохо обусловленной, в частности ![]() , т.е.

, т.е. ![]() .

.

1.4.1 Рекомендации по устранению мультиколлинеарности

Наиболее простой способ устранения мультиколлинеарности – исключение одной переменной из пары переменных, коэффициент корреляции между которыми больше 0,8.

Простейшие рекомендации по устранению мультиколлинеарности сводятся к сокращению рассматриваемого множества объясняющих переменных за счет тех из них, которые линейно связаны с уже включенными в модель. Выполнение этих рекомендаций ведет к построению сокращенной модели, которая не всегда соответствует требованию наблюдательности и управляемости. Чтобы избежать нежелательных эффектов мультиколлинеарности, сохранив при этом весь интересующий нас набор объясняющих переменных, предлагается увеличить размеры выборки путем получения дополнительной информации. Ясно, что не любое произвольное увеличение выборки ведет к ослаблению эффектов мультиколлинеарности.

Часто для устранения мультиколлинеарности используют приемы, основанные на предварительном преобразовании исходных данных путем получения отклонений от тренда. Однако, регрессионная модель, полученная благодаря таким преобразованиям, слабо поддается интерпретации. Иногда используют априорную информацию об имеющихся между параметрами связях в виде ограничений при вычислении оцениваемых параметров регрессии. За исключением простейших случаев, реализация этих подходов достигается существенным усложнением вычислительной процедуры нахождения оценок. Широкое распространение получили методы устранения мультиколлинеарности, основанные на замене исходного множества объясняющих переменных главными компонентами с последующим отбрасыванием тех из них, которые незначительны в уравнении регрессии. Близким к рассмотренному можно считать методы, основанные не на компонентном, а на факторном анализе, причем аналогия прослеживается как по достоинствам, так и по недостаткам.

В тех случаях, когда перечень объясняющих переменных регрессионной модели слишком велик, рекомендуется разделить их на группы высоко коррелированных и в каждой группе построить обобщающие факторы в виде главной компоненты, которые далее используются как новые переменные строящейся модели.

1.4.2 Доверительные интервалы для уравнения регрессии

Для проведения углубленного анализа уравнения регрессии прежде всего необходимо убедиться в том, что вектор ошибок Е распределен по нормальному закону. Для построения доверительных интервалов коэффициентов модели, предсказанных значений уравнения регрессии, среднего значения используются стандартные статистические распределения, требующие нормальности распределений.

1.4.3 Определение доверительного интервала для истинного значение уравнения регрессии

Определение доверительного интервала сводится к отысканию интервала, в котором с вероятностью ![]() содержится истинное значение

содержится истинное значение ![]() , соответствующее некоторому опыту

, соответствующее некоторому опыту ![]() из матрицы наблюдений

из матрицы наблюдений ![]() .

.

Другими словами, имеется интервал, в котором с заданной вероятностью находится линия регрессии.

Подставляя ![]() в эмпирическое уравнение регрессии получим оценки

в эмпирическое уравнение регрессии получим оценки ![]() для каждого наблюдения

для каждого наблюдения ![]() вида:

вида:

![]()

Различие между ![]() и

и ![]() объясняется действием различных ошибок.

объясняется действием различных ошибок.

Отметим, что ![]() имеет случайный характер, оценки

имеет случайный характер, оценки ![]() и

и ![]() распределены нормально с параметрами

распределены нормально с параметрами

![]() ,

,

![]() .

.

Можно утверждать, что ![]() . Другими словами y является состоятельной оценкой истинного значения

. Другими словами y является состоятельной оценкой истинного значения ![]() , соответствующего опыту

, соответствующего опыту ![]() , т.е. при неограниченном числе опытов эмпирическая линия регрессии совпадает с действительной зависимостью

, т.е. при неограниченном числе опытов эмпирическая линия регрессии совпадает с действительной зависимостью

![]()

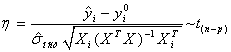

Составляя дробь Стьюдента, получаем:

.

.

Задавшись уровнем значимости ![]() и найдя табличное значение

и найдя табличное значение ![]() можно построить достоверный интервал для

можно построить достоверный интервал для ![]() в виде

в виде

![]() .

.

Похожие работы

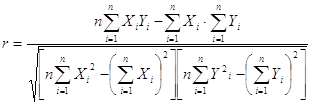

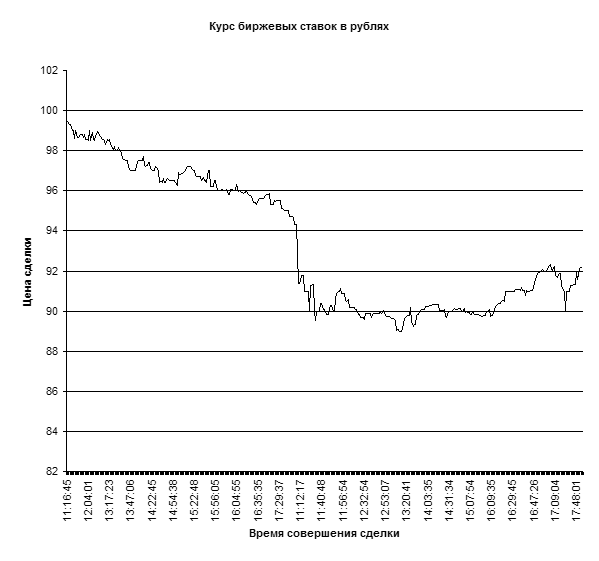

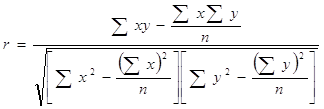

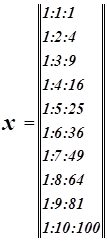

... быстро выполняемой счетной операцией. Данная работа посвящена изучению возможности обработки статистических данных биржевых ставок методами корреляционного и регрессионного анализа с использованием пакета прикладных программ Microsoft Excel. Роль корреляцонно-регрессионного анализа в обработке экономических данных Корреляционный анализ и регрессионный анализ являются смежными разделами ...

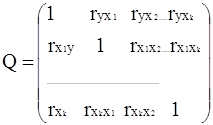

... 9472;───────┴─────────┘ Реализация алгоритма многомерного регрессионного анализа начинается с расчета важнейших статистических характеристик исходной информации и матрицы выборочных парных коэффициентов корреляции. Рассмотрим более подробно вариационные характеристики переменной у: ...

... ŷ = a0 + a1x , где ŷ - теоретические значения результативного признака, полученные по уравнению регрессии; a0 , a1 - коэффициенты (параметры) уравнения регрессии. Задача регрессионного анализа состоит в построении модели, позволяющей по значениям независимых показателей получать оценки значений зависимой переменной. Регрессионный анализ является основным средством исследования ...

... на зависимую и определение расчётных значений зависимой переменной (функции регрессии). Решение всех названных задач приводит к необходимости комплексного использования этих методов. Корреляционный и регрессионный анализ. Исследование связей в условиях массового наблюдения и действия случайных факторов осуществляется, как правило, с помощью экономико-статистических моделей. В широком смысле ...

0 комментариев