Навигация

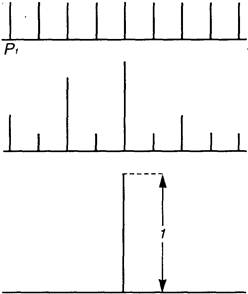

Отсюда, k=7. Следовательно, нам необходимо сделать не менее 7 взвешиваний (достаточно семи)

Формула Хартли отвлечена от семантических и качественных, индивидуальных свойств рассматриваемой системы (качества информации, содержащейся в системе, в проявлениях системы с помощью рассматриваемых N состояний системы). Это основная положительная сторона этой формулы. Но имеется и основная отрицательная сторона: формула не учитывает различимость и различность рассматриваемых N состояний системы.

Уменьшение (увеличение) Н может свидетельствовать об уменьшении (увеличении) разнообразия состояний N системы.

Обратное, как это следует из формулы Хартли (основание логарифма берётся больше 1), - также верно.

2.Мера К. Шеннона. Формула Шеннона дает оценку информации независимо, отвлеченно от ее смысла:

n I = — å pi log2 pi , i=1

где n - число состояний системы; рi - вероятность (или относительная частота) перехода системы в i-ое состояние, причем сумма всех pi равна 1.

Если все состояния равновероятны (т.е. рi=1 /n), то I=log2n.

К. Шенноном доказана теорема о единственности меры количества информации. Для случая равномерного закона распределения плотности вероятности мера Шеннона совпадает с мерой Хартли. Справедливость и достаточная универсальность формул Хартли и Шеннона подтверждается и данными нейропсихологии.

Пример. Время t реакции испытуемого на выбор предмета из имеющихся N предметов линейно зависит от log2N: t=200+180log2N (мс). По аналогичному закону изменяется и время передачи информации в живом организме. В частности, один из опытов по определению психофизиологических реакций человека состоял в том, что перед испытуемым большое количество раз зажигалась одна из n лампочек, которую он должен указать. Оказалось, что среднее время, необходимое для правильного ответа испытуемого, пропорционально не числу n лампочек, а именно величине I определяемой по формуле Шеннона, где pi - вероятность зажечь лампочку номер i.

Сообщение о наступлении события с меньшей вероятностью несёт в себе больше информации, чем сообщение о наступлении события с большей вероятностью. Сообщение о наступлении достоверно наступающего события несёт в себе нулевую информацию (и это вполне ясно, - событие всё равно произойдёт когда-либо).

Если в формуле Шеннона обозначить fi = —n log2 pi , то получим, что I можно понимать как среднеарифметическое величин fi .

Отсюда, fi можно интерпретировать как информационное содержание символа алфавита с индексом i и величиной pi вероятности появления этого символа в сообщении, передающем информацию.

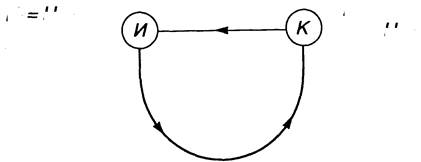

Основными положительными сторонами формулы Шеннона является её отвлечённость от семантических и качественных, индивидуальных свойств системы, а также то, что в отличие от формулы Хартли она учитывает различность, разновероятность состояний - формула имеет статистический характер (учитывает структуру сообщений), делающий эту формулу удобной для практических вычислений. Основные отрицательные стороны формулы Шеннона: она не различает состояния (с одинаковой вероятностью достижения, например), не может оценивать состояния сложных и открытых систем и применима лишь для замкнутых систем, отвлекаясь от смысла информации.

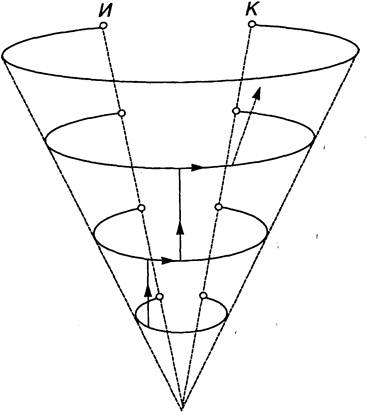

Увеличение (уменьшение) меры Шеннона свидетельствует об уменьшении (увеличении) энтропии (организованности) системы. При этом энтропия может являться мерой дезорганизации систем от полного хаоса (S=Smax) и полной информационной неопределённости (I=Imin) до полного порядка (S=Smin) и полной информационной определённости (I=Imax) в системе.

Пример. Чем ближе движущийся объект к нам, тем полнее информация обрабатываемая нашими органами чувств, тем чётче и более структурирован (упорядочен) объект. Чем больше информации мы имеем о компьютерной технике, тем меньше психологический барьер перед ним (согласно основному соотношению между энтропией и информацией).

3. Термодинамическая мера. Информационно-термодинамический подход связывает величину энтропии системы с недостатком информации о её внутренней структуре (не восполняемым принципиально, а не нерегистрируемым). При этом число состояний определяет, по существу, степень неполноты наших сведений о системе.

Пусть дана термодинамическая система (процесс) S, а Н0, Н1 - термодинамические энтропии системы S в начальном (равновесном) и конечном состояниях термодинамического процесса, соответственно. Тогда термодинамическая мера информации (негэнтропия) определяется формулой:

Н(Н0,Н1)=Н0 — Н1.

Эта формула универсальна для любых термодинамических систем. Уменьшение Н(Н0,Н1) свидетельствует о приближении термодинамической системы S к состоянии статического равновесия (при данных доступных ей ресурсах), а увеличение - об удалении.

Поставим некоторый вопрос о состоянии некоторой термодинамической системы. Пусть до начала процесса можно дать p1 равновероятных ответов на этот вопрос (ни один из которых не является предпочтительным другому), а после окончания процесса - p2 ответов. Изменение информации при этом:

D I = k ln(p1 / p2) = k (ln p1 — ln p2 ).

Если p1 > p2 (D I >0) - прирост информации, т.е. сведения о системе стали более определёнными, а при p10 - более низкой организации).

Термодинамическая мера (энтропия) применима к системам, находящимся в тепловом равновесии. Для систем, далёких от теплового равновесия, например, живых биосистем, мера - энтропия - менее подходящая.

4. Энергоинформационная (квантово-механическая) мера. Энергия (ресурс) и информация (структура) - две фундаментальные характеристики систем реального мира, связывающие их вещественные, пространственные, временные характеристики. Сейчас актуально говорить о биоэнергоинформационных мерах, отражающих механизм взаимосвязей биофизикоинформационных и вещественно-энергетических процессов в системе, в ноосфере.

Похожие работы

... порядок чередования букв формируется согласно правилам, заданным верхними иерархическими уровнями текста, то есть не «снизу вверх», а «сверху вниз». Что же касается используемой теорией информации вероятностной функции энтропии, то она может быть использована в качестве точного математического инструмента только на нижних уровнях иерархии текста, поскольку только на этих уровнях удается найти ...

... когда с момента возникновения новой парадигмы не прошло и ста лет многие ученые высказывают предположения о близости новых глобальных революционных изменений в научной картине мира. 2. Энтропия в современной картине мира 2.1 Синергетика В классической науке господствовало убеждение, что материи свойственна тенденции к понижению степени ее упорядоченности, стремление к равновесию, что ...

... числа микросостояний, посредством которых реализуется макросостояние. В состоянии равновесия энтропия достигает максимального значения, поскольку в равновесном состоянии термодинамическая вероятность максимальна. Отсюда следует, что энтропия изолированной предоставленной самой себе системы должна возрастать до тех пор, пока не достигнет максимального значения, совместимого с условиями. Следует ...

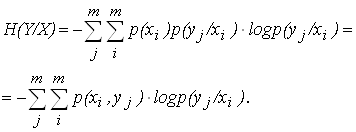

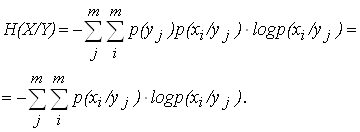

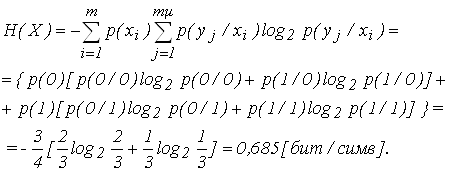

... 2. Таблица 2 Y X y1 y2 ym x1 x2 xm p(x1/y1) p(x1/y2) . . . p(x1/ym) p(x2/y1) p(x2/y2) . . . p(x2/ym) p(xm/y1) p(xm/y2) . . . p(xm/ym) Вероятности расположения на диагонали характеризует вероятность правильной передачи, остальные – ложной. Для равновероятных сигналов на входе приемника общая условная энтропия вычисляется по формуле: . (6) Для не равновероятных ...

0 комментариев