Навигация

Форма и язык представления информации

2.1. Форма и язык представления информации

2.2. Кодирование информации выясняются:

· что является основой представления информации,

· какие бывают формы представления информации,

· что такое код и кодирование информации,

· какие единицы измерения используются для определения объема информации.

Так независимо от формы представления и способа передачи, информация передается с помощью какого-либо языка. Языки делятся на естественные (разговорные) и формальные. Основу любого языка составляет алфавит – набор однозначно определенных знаков (символов), из которых формируется сообщение.

Понятия кода и кодирования вводятся следующим образом: код – набор символов (условных обозначений) для представления информации; кодирование – процесс представления информации в виде кода. На примерах приводятся различные способы кодирования информации, один из них – способ представления информации с помощью языка, содержащего два символа алфавита — 0 и 1. «Эти два символа 0 и 1 принято называть двоичными цифрами или битами (от англ. binary digit −двоичный знак)». Дается определение бита: бит – наименьшая единица измерения объема информации, а также приводится таблица более крупных единиц измерения информации.

В учебном пособии под редакцией Семакина И.Г. – это пособие по информатике для 7-9 классов [2] тема измерения количества информации рассмотрена в разделе «Человек и информация» в параграфе «Количество информации».

В учебнике материал дается в двух частях:

Часть I. Базовый курс информатики. Основная часть.

Часть II. Материал для углубленного изучения базового курса.

В обеих частях присутствует тема «Количество информации»

В первой части количество информации определяется с точки зрения алфавитного подхода. «Алфавитный подход позволяет измерять информацию, заключенную в тексте на некотором языке (естественном или формальном)». Вводятся понятия «мощность алфавита» (это полное число символов в алфавите), «информационный вес», «двоичный алфавит», и говорится о том, что информационный вес символа двоичного алфавита принят за единицу информации и называется 1 бит. Вводится формула: ![]() , где

, где ![]() — информационный вес каждого символа, а

— информационный вес каждого символа, а ![]() — мощность алфавита, причем объяснен каждый шаг того, каким образом появляется данная формула. Приводится таблица перевода одних единиц измерения информации в другие.

— мощность алфавита, причем объяснен каждый шаг того, каким образом появляется данная формула. Приводится таблица перевода одних единиц измерения информации в другие.

Во второй части данная тема раскрывается в трех пунктах:

1.1. Неопределенность знаний и единица информации

1.2. Вероятность и информация

1.3. Алфавитный подход и вероятность

Здесь обсуждаются два подхода к измерению информации: содержательный и алфавитный.

При изучении содержательного подхода дается определение единицы измерения информации (сообщение, уменьшающее неопределенность знаний в два раза, несет 1 бит информации), достаточно подробно, с примерами объясняется, что такое неопределенность знаний события (это количество возможных результатов события), что такое равновероятные события. Пошагово объясняется, как выводится формула для определения количества информации для равновероятных событий.

Рассматривается случай и неравновероятных событий. Приводятся примеры таких событий, объясняется, как подсчитывается количество информации в таких случаях.

В изучении алфавитного подхода отличительной особенностью является рассмотрение формулы Клода Шеннона для оценки средней информативности символов алфавита с учетом разной вероятности их встречаемости.

В учебном пособии под редакцией Н.Д. Угриновича − это пособие по информатике для 8 класса [3].

Тема измерения количества информации здесь рассматривается в главе «Информация и информационные процессы» в пункте

1.3. Количество информации разделяется на следующие подпункты:

1.3.1.Количество информации как мера уменьшения неопределенности знания

1.3.2. Определение количества информации

1.3.3. Алфавитный подход к определению информации

В этом учебном пособии последовательно прослеживаются два подхода к измерению информации: с точки зрения содержательной и кибернетической (алфавитной) концепций.

«Количество информации можно рассматривать как меру уменьшения неопределенности знания при получении информационных сообщений. Рассмотренный выше подход к информации как мере уменьшения неопределенности знания позволяет количественно измерять информацию. Существует формула, которая связывает между собой количество возможных информационных сообщений ![]() и количество информации

и количество информации ![]() , которое несет полученное сообщение:

, которое несет полученное сообщение: ![]() ». «За единицу количества информации принимается такое количество информации, которое содержится в информационном сообщении, уменьшающем неопределенность знания в два раза. Такая единица называется битом».

». «За единицу количества информации принимается такое количество информации, которое содержится в информационном сообщении, уменьшающем неопределенность знания в два раза. Такая единица называется битом».

Далее рассматриваются более крупные единицы измерения количества информации, и приводится таблица перевода одних единиц измерения в другие.

При алфавитном подходе к определению количества информации отвлекаются от содержания информации и рассматривают информационное сообщение как последовательность знаков определенной знаковой системы. «Информационная емкость знака двоичной знаковой системы составляет 1 бит. Чем большее количество знаков содержит алфавит знаковой системы, тем большее количество информации несет один знак».

Поясняется, как определить количество информации в сообщении: «Сообщение состоит из последовательности знаков, каждый из которых несет определенное количество информации. Если знаки несут одинаковое количество информации, то количество информации ![]() в сообщении можно подсчитать, умножив количество информации

в сообщении можно подсчитать, умножив количество информации ![]() , которое несет один знак, на длину кода (количество знаков в сообщении)

, которое несет один знак, на длину кода (количество знаков в сообщении)

![]() :

: ![]() »

»

Похожие работы

... раза. В силу специфичности информации схемы определения количества информации, связанные с ее содержательной стороной, оказываются не универсальными. Универсальным оказывается алфавитный подход к измерению количества информации. В этом подходе сообщение, представленное в какой-либо знаковой системе, рассматривается как совокупность сообщений о том, что заданная позиция в последовательности ...

... , равное 9). Заметим, что 7=8-1=23-1. Чтобы представить следующее за 7 число 8 (=23), потребуется уже четыре бита: . Значит, используя три бита, можно записывать восемь десятичных чисел от 0 до 7. А если для записи десятичного числа в двоичном виде используется четыре бита? Наибольшее число, двоичный код которого состоит из четырех битов, равно 15: в его двоичном коде все четыре бита, равны ...

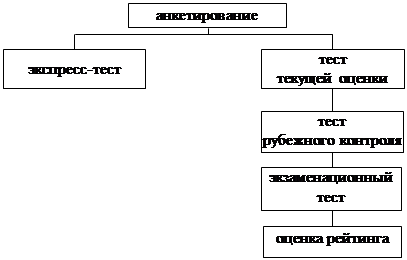

... составление заданий в тестовой форме, создание тестовых заданий и моделирование теста как системы заданий возрастающей трудности, обеспечивающей качество и эффективность педагогических измерений. Первым этапом разработки педагогического теста является разработка заданий в тестовой форме. Овладение формой является необходимым, но недостаточным условием для разработки качественного теста. На первом ...

... полезно учителю при подготовке рассказа на уроке. В данной публикации сделана попытка выделить тот самый минимум, который ученику необходимо включить в свой ответ на экзамене. Примечания для учеников При ответе надо быть готовым к дополнительным вопросам об обосновании тех или иных утверждений. Например, каковы максимальное и минимальное значения 8-битного целого числа со знаком и почему их ...

0 комментариев