Ларько А.А., инженер, ЗАО “Инфоцентр”

Рассматривается новая “кривая обобщения” - график зависимости критерия (условно названным волновым), основанного на теореме Байеса, от размера (структуры) нейросети. Вычислительные эксперименты показывают, что локальные минимумы данного критерия хорошо соответствуют свойству традиционной зависимости - ошибки обобщения от размера нейросети. Критерий может быть использован для определения оптимального размера нейросети при отсутствии тестовой выборки.

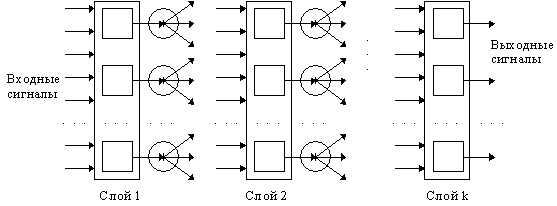

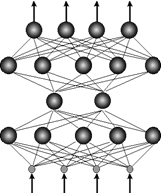

1. Задача определения оптимального размера нейросетиПри создании нейросетей важной задачей является нахождение оптимального размера сети – такого числа скрытых слоёв и нейронов в слоях, которые дадут минимум ошибки обобщения, особенно в случае отсутствия независимой тестовой выборки или сложностью разделить выборку данных на обучающую и тестовую часть.

Поэтому широко используется парадигма “кривых обучения” - зависимостей ошибок обучения и обобщения от размеров нейросети [1,2]. Оптимуму соответствуют локальные минимумы или моменты выхода графиков на асимптоты.

Другим классом кривых обучения являются зависимости внутренних свойств нейросети от её размера, сопоставляемые затем с ошибкой обобщения. Например – анализ [1] внутреннего представления задачи, связь ошибки обучения и максимума суммы модулей весов синапсов, приходящихся на нейрон сети, NIC – критерий, сопоставление вектора средних значений модулей весов синапсов [3] и ошибки обобщения. Такие критерии позволяют обходиться без тестовой выборки.

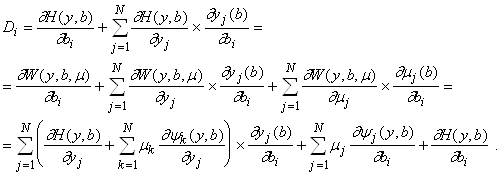

В работе предлагается новый вариант кривой обобщения – зависимость волнового критерия, от размера (структуры) нейросети. В формализованном виде задача состоит в выборе наилучшей модели (гипотезы, объясняющей наблюдаемые данные) из некоторого доступного множества. Для решения этой задачи надо оценить степень достоверности той или иной гипотезы. Обозначим весь набор имеющихся данных ![]() , а гипотезы, объясняющие эти данные (в нашем случае - нейросети), как

, а гипотезы, объясняющие эти данные (в нашем случае - нейросети), как ![]() . Предполагается, что каждая такая гипотеза объясняет данные с большей или меньшей степенью вероятности

. Предполагается, что каждая такая гипотеза объясняет данные с большей или меньшей степенью вероятности ![]() . Теорема Байеса дает решение обратной задачи - определить степень достоверности гипотез

. Теорема Байеса дает решение обратной задачи - определить степень достоверности гипотез![]() , исходя из их успехов в объяснении данных. Согласно этой теореме, достоверность гипотезы пропорциональна её успеху, а также её априорной вероятности

, исходя из их успехов в объяснении данных. Согласно этой теореме, достоверность гипотезы пропорциональна её успеху, а также её априорной вероятности ![]() , известной из других соображений, не относящихся к данной серии наблюдений:

, известной из других соображений, не относящихся к данной серии наблюдений:

(1)

(1)

Наилучшая модель определяется максимизацией ![]() .

.

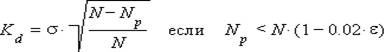

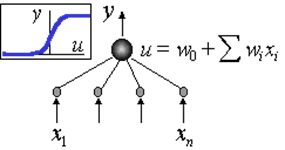

Условием максимума вероятности ![]() является минимум ошибки данных на обучающем наборе данных. Наиболее широко используемым методом минимизацией ошибки данных, является метод наименьших квадратов (МНК). В предлагаемом критерии используется модифицированная оценка ошибки по МНК , имеющая вид:

является минимум ошибки данных на обучающем наборе данных. Наиболее широко используемым методом минимизацией ошибки данных, является метод наименьших квадратов (МНК). В предлагаемом критерии используется модифицированная оценка ошибки по МНК , имеющая вид:

и (2)

где ![]() - среднеквадратичная ошибка, N – количество примеров в наборе данных используемых для обучения,

- среднеквадратичная ошибка, N – количество примеров в наборе данных используемых для обучения,![]() - допуск на точность отклика нейросети (выраженный в процентах), Np – количество правильных ответов нейросети на обучающем наборе данных, Kd – значение оценки ошибки данных.

- допуск на точность отклика нейросети (выраженный в процентах), Np – количество правильных ответов нейросети на обучающем наборе данных, Kd – значение оценки ошибки данных.

Для максимизации вероятности ![]() , в предлагаемом критерии используется известный факт из теории автоматического регулирования - чем меньше колебательность переходного процесса, тем больше устойчивость регулятора. Как показано в работе [4], устойчивость модели напрямую связана с обобщающей способностью модели (нейросети). Оценка колебательности функции ошибки нейросети имеет вид:

, в предлагаемом критерии используется известный факт из теории автоматического регулирования - чем меньше колебательность переходного процесса, тем больше устойчивость регулятора. Как показано в работе [4], устойчивость модели напрямую связана с обобщающей способностью модели (нейросети). Оценка колебательности функции ошибки нейросети имеет вид:

![]() (3)

(3)

где N – количество примеров в наборе данных используемых для обучения, ![]() - допуск на точность отклика нейросети выраженный в процентах, F - количество колебаний функции ошибки данных (численно равное количеству раз смены знака ошибки, на обучающем наборе данных), f – неравномерность колебаний функции ошибки данных, K – значение оценки колебательности функции ошибки нейросети.

- допуск на точность отклика нейросети выраженный в процентах, F - количество колебаний функции ошибки данных (численно равное количеству раз смены знака ошибки, на обучающем наборе данных), f – неравномерность колебаний функции ошибки данных, K – значение оценки колебательности функции ошибки нейросети.

Так как в выражении (1), значение знаменателя, для всех нейросетей обученных на конкретном наборе данных одинаково, условно будем считать его равным единице, тогда максимум ![]() , будет соответствовать минимуму волнового критерия W равного:

, будет соответствовать минимуму волнового критерия W равного:

![]() (4)

(4)

где K – значение оценки колебательности, Kd – значение оценки ошибки данных.

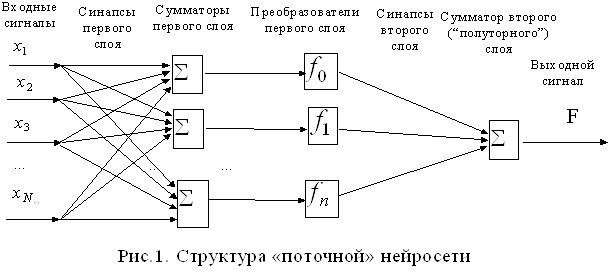

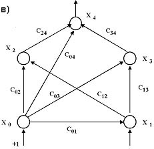

2. Данные для экспериментальной проверки и результатыБыли взяты 4 базы данных fmtrain, mat1, mat2, mat3, имеющие независимые тестовые наборы, доступные на страничке http://www-ee.uta.edu/eeweb/IP/training_data_files.htm , все задачи представляют задачи регрессии с учителем. Использовались нейросети с одним скрытым слоем и сигмоидной функцией активации, при обучении использовались разные методы оптимизации (градиентный спуск, сопряжённых градиентов, BFGS, модифицированный ParTan) и разные целевые функции (минимум суммы модулей ошибки, минимум среднеквадратичной ошибки, минимум модуля максимальной ошибки). Использовались программные средства NeuroPro 0.25, Deductor Studio. Всего было проанализировано около 1000 нейросетей.

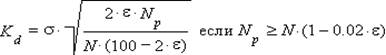

На рисунке представлены графики, для базы данных fmtrain: среднего значения ошибки обобщения (выраженные в процентах доли неправильно решённых примеров в тестовом наборе данных), среднего значения волнового критерия (приведённого к общему масштабу). Вдоль оси ординат отложено число нейронов в скрытом слое нейросети.

Для определения коэффициента корреляции между ошибкой обобщения полученной экспериментальным путём и оценкой ошибки обобщения вычисленной по волновому критерию, было сделано следующее: каждой нейросети (модели) поставлена в соответствие ошибка обобщения, выраженная числом правильно решённых примеров, проведено ранжирование нейросетей по убыванию числа решённых примеров и по возрастанию оценки ошибки обобщения, вычисленной по волновому критерию.

В результате эксперимента определены значения: K - коэффициента корреляции между множествами ранжированных нейросетей, E - ошибки обобщения лучшей нейросети найденной опытным путём, W - ошибки обобщения лучшей нейросети найденной с помощью волнового критерия.

Результаты эксперимента приведены в таблице.

| Нейросети (модели) | К | Е,% | W,% |

| Нейросети базы данных fmtrain | 0,96863 | 14 | 14 |

| Нейросети базы данных mat1 | 0,99666 | 14 | 14 |

| Нейросети базы данных mat2 | 0,99993 | 14,7 | 14,7 |

| Нейросети базы данных mat3 | 0,99794 | 13,7 | 14,7 |

| Коллектив нейросетй вида | 0,92953 | 4,59 | 4,59 |

| Множество моделей, состоящее из нейросетей и моделей полученных методами параметрической статистики, база данных - отрезок функции y = sin(x) | 0,97912 | 0 | 0 |

Рис. Зависимость ошибки обобщения (процент неправильно решённых примеров тестового набора данных) от числа нейронов в скрытом слое нейросети (сплошной линией показан результат эксперимента, штриховой линией значения волнового критерия).

Как видно из экспериментальных данных предложенный волновой критерий хорошо соответствует кривой обобщения, предоставляя возможность исключить проверку на тестовом наборе данных и обучать нейросеть на всём доступном наборе данных, не разделяя его на обучающий и тестовый фрагменты.

3. ЗаключениеПредложен новый вариант кривой обучения – зависимость значения волнового критерия от обобщающих способностей нейросети (в частности от размера нейросети). Экспериментально показано, что с его помощью возможно достаточно надёжное определение оптимального размера нейросети, обеспечивающего минимум ошибки обобщения.

Также данный критерий может быть применён и для выбора лучшей модели из множества моделей полученных разными методами математической статистики.

Возможность использования данного критерия в качестве целевой функции не исследовалась, но формальных препятствий в этом направлении нет.

Список литературы

Watanabe E., Shimizu H. Relationships between internal representation and generalization ability in multi layered neural network for binary pattern classification problem /Proc. IJCNN 1993, Nagoya, Japan, 1993. Vol.2.-pp.1736-1739.

Cortes C., Jackel L., D., Solla S. A., Vapnik V., Denker J. S.. Learning curves: asymptotic values and rate of convergence / Advances in Neural Information Processing Systems 7 (1994). MIT Press, 1995. – pp. 327-334.

Царегородцев В.Г. Определение оптимального размера нейросети обратного распространения через сопоставление средних значений модулей весов синапсов. /Материалы 14 международной конференции по нейрокибернетике, Ростов-на-Дону, 2005. Т.2. – С.60-64.

Секерин А.Б. Метод оценки устойчивости нейронно-сетевых моделей. / 2005.http://zhurnal.ape.relarn.ru/articles/2005/031.pdf

Список литературы

Для подготовки данной работы были использованы материалы с сайта http://www.sciteclibrary.ru

Похожие работы

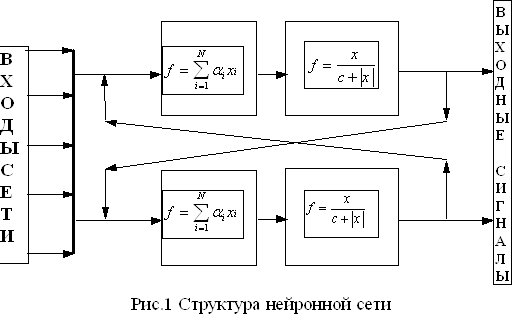

... экспертных систем (А. Батуро), а также лекции проф. А.Н. Горбаня по нейронным сетям. Приложение 1. Плакаты для защиты диплома. ТЕХНОЛОГИЯ ИЗВЛЕЧЕНИЯ ЗНАНИЙ ИЗ НЕЙРОННЫХ СЕТЕЙ: ¨ АПРОБАЦИЯ, ¨ ПРОЕКТИРОВАНИЕ ПО, ¨ ИСПОЛЬЗОВАНИЕ В ПСИХОЛИНГВИСТИКЕ ЦЕЛЬ РАБОТЫ ¨ апробация гибкой технологии извлечения ...

... сети, позволяющая реализовать автоматическое изменение числа нейронов в зависимости от потребностей задачи, позволяет не только исследовать, но и контролировать процесс воспитания психологической интуиции искусственных нейронных сетей. - Впервые применена выборочная константа Липшица для оценки необходимой для решения конкретной задачи структуры нейронной сети. Практическая значимость ...

... именно метод скользящего экзамена или некоторые его вариации. Стоит отметить, что эффективность статистических методов классификации сейсмических сигналов также проверяется методом скользящего экзамена. Таким образом, применяя его для тестирования нейросетевого подхода, можно корректно сравнить результаты экспериментов с возможностями стандартных методов. 7. Программная реализация. При ...

... данных а разбивать входные данные на кластеры. •Рекурсивные сети Элмана, способные обрабатывать последовательности векторов. •Вероятностные сети, аппроксимирующие Байесовские классификаторы с любой степенью точности. Общие принципы, характерные для нейросетей Согласно общепринятым представлениям наиболее общими принципами, характерными для современных нейросетей являются: коннекционизм, ...

0 комментариев