Навигация

Расчёт информационных характеристик источников дискретных сообщений

1. Расчёт информационных характеристик источников дискретных сообщений

1.1 Задача № 1.38

Ансамбли событий X и Y объединены, причем вероятности совместных событий равны: ![]() ;

;![]() ;

;![]() ;

; ![]() ;

; ![]() ;

; ![]() ;

; ![]() ;

; ![]() .Найти: энтропии ансамблей X и Y соответственно

.Найти: энтропии ансамблей X и Y соответственно ![]()

![]() ; энтропию объединенного ансамбля

; энтропию объединенного ансамбля ![]() ; условные энтропии ансамблей

; условные энтропии ансамблей ![]()

Решение:

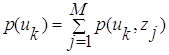

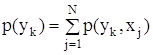

1) Известны вероятности совместных событий, и с учётом соотношения

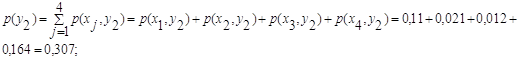

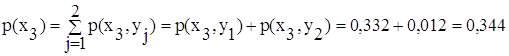

находятся безусловные вероятности p(xk) и p(yk), которые потребуются при дальнейшем решении:

![]() ;

;

![]() ;

;

;

;

;

;

.

.

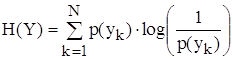

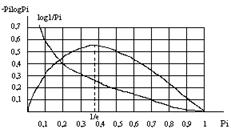

2) По формуле определения энтропии (1.4), находятся энтропии ансамблей H(X) и H(Y):

![]()

![]()

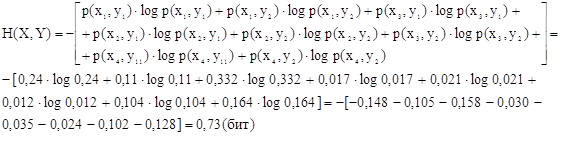

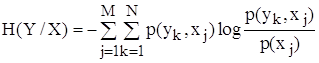

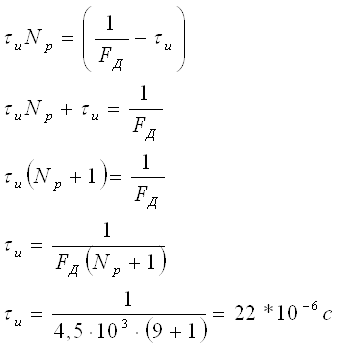

3) Для нахождения среднего количества информации, даваемое сообщением X при условии, что сообщение ансамбля Y уже известно, т.е. нахождение энтропии ансамбля H(X,Y), используется формула определения энтропии объединённого ансамбля:

![]()

т.о., в нашем случае H(X,Y) будет равна

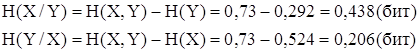

4) Итак, была найдена энтропия объединённого ансамбля. Далее по заданию требуется определить условные энтропии ансамблей H(X/Y) и H(Y/X). Формулу условной энтропии можно получить из формулы количества информации, содержащейся Y относительно X и наоборот.

1.2 Задача № 1.66

Принимаемый сигнал может иметь амплитуду ![]() (событие

(событие ![]() ) или

) или ![]() (событие

(событие ![]() ), а также сдвиг фазы

), а также сдвиг фазы ![]() (событие

(событие ![]() ) или

) или ![]() (событие

(событие ![]() ) режимах. Вероятности совместных событий имеют следующие значения:

) режимах. Вероятности совместных событий имеют следующие значения:

![]() ;

; ![]() ;

; ![]() ;

;![]() .

.

Вычислить количество информации получаемой о фазовом сдвиге сигнала, если станет известной его амплитуда.

Решение:

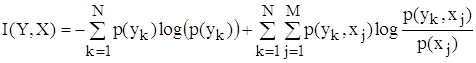

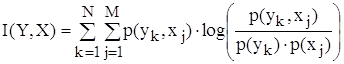

Количество информации вычисляется по формуле:

![]()

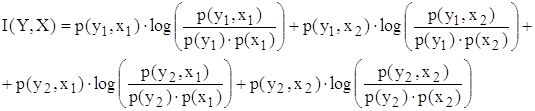

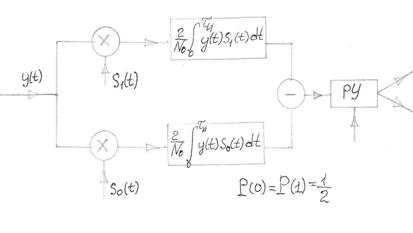

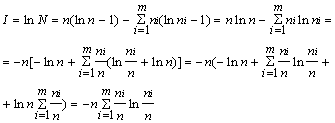

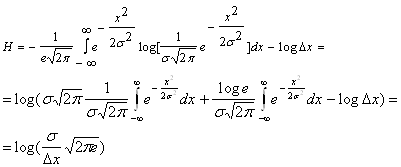

Величина I(Y,X) показывает, сколько в среднем бит информации о реализации ансамбля Y дает наблюдение реализации ансамбля Z. Подставив в эту формулу в выражение для вычисления энтропии и условной энтропии:

Учитывая, что

,

,

последнее выражение можно записать в виде:

Вычисляются необходимые величины.

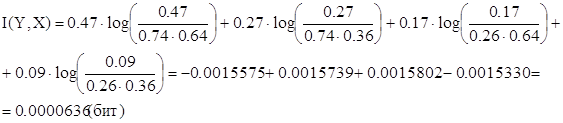

p(y1) = p(x1, y1) + p(x2, y1) = 0.47 + 0.27 = 0.74

p(y2) = p(x1, y2) + p(x2, y2) = 0.17 + 0.09 = 0.26

p(x1) = p(x1, y1) + p(x1, y2) = 0.47 + 0.17 = 0.64

p(x2) = p(x2, y1) + p(x2, y2) = 0.27 + 0.09 = 0.36

Все величины подставляются в формулу:

Похожие работы

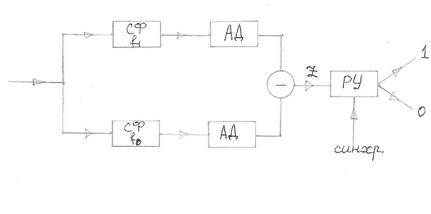

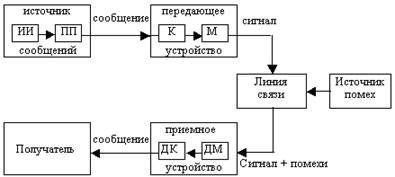

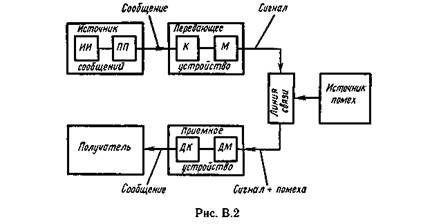

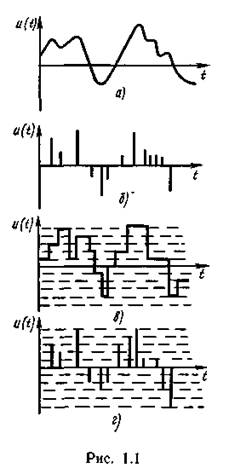

... дискретным каналом. При этом необходимо преобразовать непрерывное сообщение в цифровой сигнал, т.е. в последовательность символов, сохранив содержащуюся в сообщении существенную часть информации. Типичными примерами цифровых систем передачи непрерывных сообщений являются системы с импульсно–кодовой модуляцией (ИКМ) и дельта–модуляцией (ДМ). Для преобразования непрерывного сообщения в цифровую ...

... , работавших в области электротехники, заинтересовалась возможностью создания технологии хранения данных, обеспечивающей более экономное расходование пространства. Одним из них был Клод Элвуд Шеннон, основоположник современной теории информации. Из разработок того времени позже практическое применение нашли алгоритмы сжатия Хаффмана и Шеннона-Фано. А в 1977 г. математики Якоб Зив и Абрахам Лемпел ...

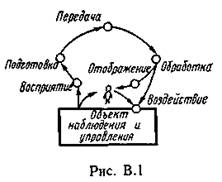

... связано с приложением теории в технике связи - рассмотрением проблемы разработки конкретных методов и средств кодирования сообщений, то совокупность излагаемых вопросов называют теорией информации и кодирования или прикладной теорией информации. Другая точка зрения состоит в том, что глобальной проблемой теории информации следует считать разработку принципов оптимизации системы связи в целом. В ...

... обратный процесс - преобразование цифрового сигнала в аналоговый. В данной курсовой работе необходимо рассчитать технические характеристики цифровой системы связи. . 1. СТРУКТУРНАЯ СХЕМА СИСТЕМЫ ЦИФРОВОЙ ПЕРЕДАЧИ НЕПРЕРЫВНЫХ СООБЩЕНИЙ. Для передачи непрерывных сообщений можно воспользоваться дискретным каналом. При этом необходимо преобразовать непрерывное сообщение в цифровой сигнал, то есть в ...

0 комментариев