Навигация

Структура сети Кохонена

2.1 Структура сети Кохонена

Сеть Кохонена использует следующую модель (рисунок 2.1): сеть состоит из М нейронов, образующих прямоугольную решетку на плоскости — слой.

Рисунок 2.1 – Модель сети Кохонена

К нейронам, расположенным в одном слое, представляющем собой двумерную плоскость, подходят нервные волокна, по которым поступает N-мерный входной сигнал. Каждый нейрон характеризуется своим положением в слое и весовым коэффициентом. Положение нейронов, в свою очередь, характеризуется некоторой метрикой и определяется топологией слоя, при которой соседние нейроны во время обучения влияют друг на друга сильнее, чем расположенные дальше. Каждый нейрон образует взвешенную сумму входных сигналов с ![]() , если синапсы ускоряющие, и

, если синапсы ускоряющие, и ![]() - если тормозящие. Наличие связей между нейронами приводит к тому, что при возбуждении одного из них можно вычислить возбуждение остальных нейронов в слое, причем это возбуждение с увеличением расстояния от возбужденного нейрона уменьшается. Поэтому центр возникающей реакции слоя на полученное раздражение соответствует местоположению возбужденного нейрона. Изменение входного обучающего сигнала приводит к максимальному возбуждению другого нейрона и соответственно — к другой реакции слоя. Сеть Кохонена может рассматриваться как дальнейшее развитие LVQ (Learning Vector Quantization). Отличие их состоит в способах обучения.

- если тормозящие. Наличие связей между нейронами приводит к тому, что при возбуждении одного из них можно вычислить возбуждение остальных нейронов в слое, причем это возбуждение с увеличением расстояния от возбужденного нейрона уменьшается. Поэтому центр возникающей реакции слоя на полученное раздражение соответствует местоположению возбужденного нейрона. Изменение входного обучающего сигнала приводит к максимальному возбуждению другого нейрона и соответственно — к другой реакции слоя. Сеть Кохонена может рассматриваться как дальнейшее развитие LVQ (Learning Vector Quantization). Отличие их состоит в способах обучения.

Сеть Кохонена, в отличие от многослойной нейронной сети, очень проста; она представляет собой два слоя: входной и выходной. Элементы карты располагаются в некотором пространстве, как правило, двумерном.

Сеть Кохонена обучается методом последовательных приближений. В процессе обучения таких сетей на входы подаются данные, но сеть при этом подстраивается не под эталонное значение выхода, а под закономерности во входных данных. Начинается обучение с выбранного случайным образом выходного расположения центров.

В процессе последовательной подачи на вход сети обучающих примеров определяется наиболее схожий нейрон (тот, у которого скалярное произведение весов и поданного на вход вектора минимально). Этот нейрон объявляется победителем и является центром при подстройке весов у соседних нейронов. Такое правило обучения предполагает "соревновательное" обучение с учетом расстояния нейронов от "нейрона-победителя".

Обучение при этом заключается не в минимизации ошибки, а в подстройке весов (внутренних параметров нейронной сети) для наибольшего совпадения с входными данными.

Основной итерационный алгоритм Кохонена последовательно проходит ряд эпох, на каждой из которых обрабатывается один пример из обучающей выборки. Входные сигналы последовательно предъявляются сети, при этом желаемые выходные сигналы не определяются. После предъявления достаточного числа входных векторов синаптические веса сети становятся способны определить кластеры. Веса организуются так, что топологически близкие узлы чувствительны к похожим входным сигналам.

В результате работы алгоритма центр кластера устанавливается в определенной позиции, удовлетворительным образом кластеризующей примеры, для которых данный нейрон является "победителем". В результате обучения сети необходимо определить меру соседства нейронов, т.е. окрестность нейрона-победителя, которая представляет собой несколько нейронов, которые окружают нейрон-победитель.

Сначала к окрестности принадлежит большое число нейронов, далее ее размер постепенно уменьшается. Сеть формирует топологическую структуру, в которой похожие примеры образуют группы примеров, близко находящиеся на топологической карте.

Рассмотрим это более подробнее. Кохонен существенно упростил решение задачи, выделяя из всех нейронов слоя лишь один с-й нейрон, для которого взвешенная сумма входных сигналов максимальна:

![]() . (2.1)

. (2.1)

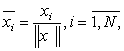

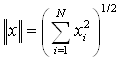

Отметим, что весьма полезной операцией предварительной об работки входных векторов является их нормализация:

(2.2)

(2.2)

превращающая векторы входных сигналов в единичные с тем же направлением.

(2.3)

(2.3)

В этом случае вследствие того, что сумма весов каждого нейрона одного слоя ![]() для всех нейронов этого слоя одинакова и

для всех нейронов этого слоя одинакова и ![]() , условие (2.1) эквивалентно условию:

, условие (2.1) эквивалентно условию:

![]() . (2.4)

. (2.4)

Таким образом, будет активирован только тот нейрон, вектор весов которого w наиболее близок к входному вектору х. А так как перед началом обучения неизвестно, какой именно нейрон будет активироваться при предъявлении сети конкретного входного вектора, сеть обучается без учителя, т. е. самообучается. Вводя потенциальную функцию — функцию расстояния ![]() («соседства») между i-м и j-м нейронами с местоположениями

(«соседства») между i-м и j-м нейронами с местоположениями ![]() и

и ![]() соответственно, монотонно убывающую с увеличением расстояния между этими нейронами, Кохонен предложил следующий алгоритм коррекции весов:

соответственно, монотонно убывающую с увеличением расстояния между этими нейронами, Кохонен предложил следующий алгоритм коррекции весов:

![]() , (2.5)

, (2.5)

где ![]() - изменяющийся во времени коэффициент усиления (обычно выбирают

- изменяющийся во времени коэффициент усиления (обычно выбирают ![]() на первой итерации, постепенно уменьшая в процессе обучения до нуля);

на первой итерации, постепенно уменьшая в процессе обучения до нуля); ![]() - монотонно убывающая функция.

- монотонно убывающая функция.

![]() , (2.6)

, (2.6)

Где ![]() и

и ![]() - векторы, определяющие положение нейронов i и j в решетке. При принятой метрике

- векторы, определяющие положение нейронов i и j в решетке. При принятой метрике ![]() функция

функция ![]() с ростом времени

с ростом времени ![]() стремится к нулю. На практике вместо параметра времени

стремится к нулю. На практике вместо параметра времени ![]() используют параметр расстояния

используют параметр расстояния ![]() , задающий величину области «соседства» и уменьшающийся с течением времени до нуля. Выбор функции

, задающий величину области «соседства» и уменьшающийся с течением времени до нуля. Выбор функции ![]() также влияет на величины весов всех нейронов в слое. Очевидно, что для нейрона-победителя

также влияет на величины весов всех нейронов в слое. Очевидно, что для нейрона-победителя ![]() :

:

![]() . (2.7)

. (2.7)

На рисунке 2.2 показан пример изменения двумерных весов карты ![]() , образующей цепь. При появлении входного образа

, образующей цепь. При появлении входного образа ![]() наиболее сильно изменяется весовой вектор нейрона-победителя 5, менее сильно — веса расположенных рядом с ним нейронов 3, 4, 6, 7. А так как нейроны 1, 2, 8, 9 лежат вне области «соседства», их весовые коэффициенты не изменяются.

наиболее сильно изменяется весовой вектор нейрона-победителя 5, менее сильно — веса расположенных рядом с ним нейронов 3, 4, 6, 7. А так как нейроны 1, 2, 8, 9 лежат вне области «соседства», их весовые коэффициенты не изменяются.

Рисунок – 2.2 Изменение весов карты Кохонена

Таким образом, алгоритм обучения сети Кохонена может быть описан так:

1. Инициализация

Весовым коэффициентам всех нейронов присваиваются малые случайные значения и осуществляется их нормализация. Выбирается соответствующая потенциальная функция ![]() и назначается начальное значение коэффициента усиления

и назначается начальное значение коэффициента усиления ![]() .

.

2. Выбор обучающего сигнала

Из всего множества векторов обучающих входных сигналов в соответствии с функцией распределения ![]() выбирается один вектор

выбирается один вектор ![]() , который представляет «сенсорный сигнал», предъявляемый сети.

, который представляет «сенсорный сигнал», предъявляемый сети.

0 комментариев